안윤호님이 2007년, 2008년 작성하신 문서. SICP에 대한 소개라고 볼 수 있다.

해커 문화의 뿌리를 찾아서

저자 안윤호

Part1: 리스프가 탄생하기까지

2007년 4월 3일

'마법사 책'이라 불린 SICP

SICP(Structure and Interpretation of Computer Programs)는 한때 미국 주요 대학들의 컴퓨터학과 필수 과정 중 하나였다. 책은 매우 어려운 편이고 책의 연습문제라는 것들에는 우수한 컴퓨터 프로그래머들이 고민하던 문제들이 포함되어 있다. 그리고 다른 책과는 그 구성이 너무 다르다. 끝부분에 가면 메타 서큘러 실행기를 거쳐 언어의 컴파일러인지, 하드웨어의 컴파일러인지 경계가 애매한 지경에까지 이른다. 학생들이 당혹해 할 것은 틀림없다. SICP는 컴퓨터 교육의 패러다임을 바꾸어 놓았다는 평을 듣기도 한다.

그림 1. 마법사 책이라고 하는 SICP의 표지.

그림에 나온 람다(lambda)와 apply-eval 개념은 책을 관통하는 주제다. 책은 http://mitpress.mit.edu/sicp/ 에 온라인 문서로 공개되어 있다.

그래서 SICP에 대해서는 많은 사람들의 의견이 반반으로 갈린다. 생각하고 배울 점이 많은 책이라는 의견과 배울 것도 없으면서 시간만 낭비하게 하는 괴상한 책이라는 견해다. 한때 이 책을 필수 학점의 교재로 사용하던 학교에서는 학생들이 과정을 따라가는 일 자체에 공포심을 느꼈으며 불평도 대단했다. 시종일관 생각하게 만든다는 것이 공포심을 갖게 하는 요인이었다. 필자 역시 처음에는 책이 너무나 이상하다고 생각해서, 보다가 두 번이나 집어 던진 기억이 있다. 필자는 강의를 들은 것이 아니라 혼자서 공부했기 때문에 책의 배경을 이해하지 못했다. 책에 대한 재평가는 SICP와 관련된 메모들과 문서들, 그리고 문서들의 역사적인 맥락을 조금이나마 알게 되면서부터다. 그리고 컴퓨터에 대해 다시 생각하게 되었다.

책에 대해 불평하던 사람들 가운데 나중에 이 책을 다시 보거나 재평가하는 사람들이 꽤 있다. 그 중에는 조엘 스폴스키(Joel Spolsky)도 있었다. 조엘은 조엘 온 소프트웨어(Joel On the Software)라는 블로그로 유명한 사람이다. 조엘의 글 중에 ""은 미국 대학의 컴퓨터 학과가 너무 쉬운 것들만 다루려고 해서 수준 저하가 올 것이라는 내용이었다.

조엘 자신이 나이를 먹었다는 확실한 징조가 "요즘 아이들이" 어려워 보이는 것들을 하려고도, 할 수 있다고도 생각하지 않는다는 현상이라고 했다. 컴퓨터 학과에서 자료구조와 함수형 언어 같은 것을 심도 있게 가르치지 않기 때문에 평이한 학생들만을 만들어 내며, 학생들은 교과 과정이 어렵지 않기 때문에 많은 생각을 하지 않고 졸업한다. 그래서 평범한 프로그램만 만들어 내는 평범한 프로그래머만이 나올 것 같다는 내용이다(예전에는 자료구조나 함수형 언어 같은 것이 너무 어려워 고교 시절까지 스스로 우수하다고 생각했던 학생들이 자신의 능력을 진지하게 생각하고 과를 바꾸는 경우가 있었다는 것이다. 과정 자체가 사람들을 솎아내는 기능이 있었다).

이렇게 어려운 교과 중 하나가 MIT 학부 과정의 SICP다. 앞서 말했듯이 과거에는 주요 대학들의 표준 교재였다. 조엘은 블로그에서 이렇게 말하고 있다

"코스의 난이도는 경이적이다. 처음 5번 정도의 강의에서 스킴(Scheme)의 대부분을 배우며 그것으로 다른 함수를 입력으로 받는 fixed-point 함수를 배울 준비가 끝난다. 펜실베니아 대학의 CSE121에서 나 자신이 이런 과정과 씨름할 때, 전부는 아니더라도 대부분은 강의를 따라갈 수 없었다. 교재는 너무 어려웠다. 교수님에게 이런 과정은 부당하다는 긴 하소연 편지를 썼다. 학교의 누군가가 내 말(아니면 다른 불평자)을 들은 것이 틀림없다. 왜냐하면 이 과정은 이제 자바로 진행되기 때문이다. … 차라리 이런 불평을 듣지 않았으면 좋았을 것이다. … 이제 전공과목에서 4.0을 받느라 머리를 쓸 필요가 없어진 것이다."

아마존의 서평은 책의 내용이 좋다('great'와 'excellent' 정도의 표현은 흔하다)는 평으로 도배되어 있다. 책의 내용이 지나치게 어렵다는 것을 불평하면서도 그렇다. 사람들이 지적하는 불만 사항은 현실적인 면에 관한 것이다. 이 책은 실전에는 바로 도움이 되지 않는다. 서평 목록 처음에 나오는 피터 노빅(구글의 검색엔진 품질 책임자로 norvig.com 에 가면 리스프에 대한 많은 글들을 볼 수 있다)이나 폴 그레이엄(비아웹의 창업자로 '해커와 화가'라는 책을 썼다. www.paulgraham.com 에 가면 역시 리스프에 대한 많은 글이 있다) 같은 사람들은 SICP에 대해 극찬 일색이다. 두 사람은 리스프의 중요한 옹호자이고 리스프 세계에서 SICP는 중요한 교과서다. 두 사람 모두 리스프에 대해 중요한 책들을 출판했지만 SICP는 아주 중요한 책으로 평가된다.

SICP의 문화 코드, 그리고 리스프

사람들이 이렇게 생각한다면 SICP는 나름대로 중요한 의미를 지닌다. 이유는 간단하다. 사람들이 중요하다고 생각하는 그 무엇이 있기 때문이다. 책에는 생각할 내용이 많은 것이다. 고전으로 평가 받는 이유는 책이 담고 있는 내용도 있지만 책을 주제로 담론을 전개할 수 있기 때문이기도 하다. 그렇다면 책이 어려워도 고생해가며 읽을 가치는 충분하다고 볼 수 있다. 물론 아닐 수도 있다.

SICP는 한글판으로도 출판된다. 필자도 부분적으로나마 번역 과정에 참여했다. 한글 번역의 문제점과 장점을 다 같이 갖고 있는 SICP의 한글판은 컴퓨터의 고전이 번역되는 것으로 볼 수 있고 중요한 의미를 갖는다. 아무래도 한글판이 나오면 한 명이라도 더 보게 되어 있다. 이를테면 예전에 Computer Organization and Design 같은 고전이 번역되자 사람들이 더 많이 읽고 더 많은 과정에서 교재로 도입했다.

그러나 SICP를 교재로 사용하고 있는 과정은 아무래도 줄고 있다. 조엘이 말한 것과 같은 맥락이다. 그러나 컴퓨터의 중요한 고전을 독학으로 공부하는 것도 가능하다. 이미 학부를 졸업한 사람들이나 관련이 없는 학과를 나온 경우에는 독학 이외에는 방법이 없다(필자 역시 독학 내지 흥미로 공부하고 이 글을 쓰고 있다).

SICP가 쉽다거나 어렵다거나 하는 문제는 교사와 학생의 문제일 수도 있으며(예상보다 높은 수준의 교사가 필요할 것이라는 것이 개인적 의견이다) 리스프나 스킴 자체의 문제일 수도 있다. 커리큘럼이 너무 어렵고 격렬하다고 하여 HTDP(How to Design Programs)와 같은 교과 과정도 있다. 그러나 분명히 이런 격렬함이 이 책을 다른 책과 다르게 만든 그 무엇이기도 하다. 이상한 주입 과정과 사고 과정을 거치면서 분명히 어떤 변화가 나타난다. 그러나 우수한 선생이나 대가에게 배울 수 없다면 우수한 학생 또는 대가학생이라는 방법도 가능하다. 학생이 목표를 선정하고 이리저리 공부하는 방법을 고안하면 된다. 실패율은 높지만 배우는 것도 많다. 아무튼 리스프나 SICP를 배우고 이해하거나 짜보고 싶은 프로그램들이 있었으므로 해봐야 할 과정이었다.

필자는 이 책을 독학하기 위해 여러 가지 자료를 살펴보아야 했고 약간의 시간을 낼 수 있어서 여러 가지를 구경할 수 있었다. 그래서 이번에 쓰는 글은 아마추어 해커의 관점에서 해커 사상의 원류라고 할 수 있는 리스프와 리스프의 중요한 파생 언어 중 하나인 스킴을 살펴보는 것이다.

필자는 컴퓨터로 먹고 살지 않는다. 진지하기는 하지만 생업은 아니다. 아마추어다. 덕분에 하고 싶은 것들을 하고 있어도 누가 뭐라고 하지 않는다. 적극적으로 보자면 컴퓨터는 필자에게 중요한 문화 탐험의 하나다. 그래서 도대체 SICP라는 책을 만들기 위한 문화코드와 재료가 무엇인지, 그리고 역사(history)와 사람들의 이야기(biography)가 어떤 것인지가 더 중요하다. 이런 날줄과 씨줄로 리스프의 문화 코드가 만들어진 것이기 때문이다. 그래서 필자의 이야기는 완전한 전문가의 이야기도 아니며 그저 진지한 아마추어의 이야기 정도로 파악해주면 좋을 것이다.

그래서 SICP라는 책을 해설하는 것이 아니라 SICP를 만든 자료들과 근거들이 어떠한 맥락에서 어떤 경로를 거쳐 발전해 왔는가를 보는 것이 필자의 접근법이다(이러한 접근법은 시간이 조금 더 든다).

SICP의 그 이전에 리스프라는 더 거대한 덩어리가 있었다. 여기에도 문서들이 보존되어 있다. 필자는 코드만 보고 '아하!' 하고 모든 것을 이해하는 천재가 아니기 때문에 이것저것을 살펴보아야 하고 문서가 있으면 다 이해하지는 못하더라도 읽어보려고 했다. 때로는 코드만 보는 것보다는 더 이해가 빠를 수도 있겠다. 자칫하면 재미가 없을 수도 있으므로 접근방법을 미리 설명하는 것이다. 그러니까 필자의 글은 어려운 SICP를 이해하기 위한 주변 자료들을 제시하고 나름대로 설명해 보고 싶은 것이다. 실제로 리스프나 스킴이 오랜 세월 동안 진화해 왔기 때문에 역사성을 무시하지 못한다. 그래서 역사적 자료와 문헌들을 사람들의 이야기와 몇 줄의 코드에 섞어서 이야기할 수밖에 없다. 교양과목들처럼 말이다.

거슬러 살펴본 리스프의 탄생

SICP는 개정 과정을 몇 차례 거쳤는데 SICP는 리스프가 아니라 리스프의 방언인 스킴으로 되어 있다. 그리고 스킴을 만든 사람은 가이 스틸(Guy Steele)과 제럴드 서스만(Gerald Sussman)이다. 그 전까지의 리스프와 스킴의 차이점이라면 스킴은 칼 휴이트(Carl Hewitt)의 액터 모델(actor model)을 구현하기 위해 만들었으며 그 이전의 다른 리스프 구현의 전통을 이어받았다는 점이다.

그런 노력의 와중에서 전통적인 리스프에 대한 심각한 의문 제기가 있었고 일련의 사고 과정은 람다 페이퍼(lambda paper)라는 이름으로 나타난다. 결국 여러 편의 논문들이 나오고 SICP라는 책으로 만들어지기까지는 10년의 세월이 필요했다. 1970년대 초반부터 작업이 시작되어 1980년대 중반에야 책으로 나온 것이다.

그림 2. 리스프를 발명(또는 발견)했다고 하는 존 매카시

그림 2. 리스프를 발명(또는 발견)했다고 하는 존 매카시

이른바 이들이 발표하는 람다 페이퍼라는 것을 사람들은 좋아하기도 했고 싫어하기도 했다(글들은 http://library.readscheme.org/page1.html에 있다). 그 중 "The Art of the Interpreter of, the Modularity Complex(Parts Zero, One, and Two)"라는 유명한 문서가 많은 사람들에게 영향을 주었다. 그 외에도 "Lambda: The Ultimate Imperative"와 "Lambda: The Ultimate Declarative", 그리고 "Debunking the 'Expensive Procedure Call' Myth, or, Procedure Call Implementations Considered Harmful, or, Lambda: The Ultimate GOTO"라는 글들도 유명하지만 사람들은 이 글들을 별로 좋아하지 않았던 것 같다. "Lambda: The Ultimate X" and "X considered Harmful"이라고 풍자하는 글들도 있었다고 한다.

중요한 내용이라 언급하지 않을 수 없는 액터 모델에 대해서도 설명하면 좋겠지만 지면상 불가능하다. 일단 위키 백과의 소개 글 정도면 큰 그림을 이해하는 데는 충분할 것이다. 휴이트와 대화하면서 람다가 액터와 같다는 것을 확인한 서스만은 정말로 좋아했다고 한다. 나중에 앨런 케이(Alan Kay)와 휴이트가 만나면서 스몰토크(smalltalk) OOP(Object-Oriented Programming)의 메시지 모델과 액터 모델은 서로 많은 영향을 주고받았다.

1970년대 스킴이 람다 페이퍼를 중심으로 사람들의 관심과 비난을 한데 얻던 시절, 서스만과 함께 스킴에 대한 연구를 진행하던 가이 스틸은 당시를 아주 재미있던 시절이라고 나중에 회고했다. 스틸은 당시 대학원을 다녔다. 석사 과정에 다니는 학생이 젊은 교수와 함께 언어의 중요한 틀을 만든 것이다. 스틸은 나중에 스킴 컴파일러에 대한 논문을 쓰고 D. Hillis의 Thinking Machine으로 자리를 옮겼기 때문에 SICP가 출판될 때는 동료인 Harold Abelson이 공동 저자로 되어 있다(가이 스틸은 현재 썬(Sun)의 연구진으로 있다). 기존의 리스프에 대해 문제점을 제기한 가이 스틸은 나중에 CLTL(Common Lisp The Language)라는 리스프 드래프트의 작성자가 되었다. 드래프트를 만들며 리스프의 많은 구현들의 장단점을 취합했다. 그만큼 실력이 있었다(스틸은 C 표준안과 자바 표준 그리고 포트란의 표준안을 작성했거나 위원회의 주요 멤버이기도 했다).

스킴이 그전까지의 리스프와 중요한 차이를 보인 것은 람다에 대한 중요성을 부각시키고 람다의 행동에 대한 엄밀한 분석을 이룬 것이다. 테일 리커전(tail recursion)이나 렉시컬 스코프(lexical scope)와 같은 것도 중요한 차이점이다. 람다에 대해 생각한 것은 앞의 오리지널 람다 페이퍼라는 문서들이 바로 그 증거이며 SICP에는 이 문서들의 내용이 녹아 들어있다. 진지한 독자들이라면 호기심으로라도 람다 페이퍼들을 살펴볼 필요는 충분히 있겠다.

튜링 머신과 람다 계산법

컴퓨터 역사에서 리스프 초기 해커들은 1세대 해커에 속한다. 바로 스티븐 레비의 "해커"에 나오는 사람들이다. SICP의 저자인 제랄드 서스만 역시 1960년대 중반에 이 문화권 속에 들어와 있었다. 스티브 러셀(Steve Russell)이나 다른 해커들과 같이 구현된 지 얼마 되지 않은 리스프와 PDP 컴퓨터를 가지고 기계들과 하나가 되어 생활했다. 이들에게 있어서 리스프와 MIT의 AI 연구소는 하나의 도약대였다. 그리고 해커 문화를 탄생시켰다. AI 연구소는 자유롭게 프로그래밍을 할 수 있는 장비와 분위기를 제공한 최초의 장소였기 때문이다. 그래서 컴퓨터의 역사에서 리스프의 위치는 매우 중요하다("A Marriage of Convenience: The Founding of the MIT Artificial Intelligence Laboratory")라는 문서가 있다).

리스프가 하나의 중요한 언어가 될 수 있었던 것은 수학적인 아이디어의 표현에서 뛰어났기 때문이다. 그것은 우선적으로 람다와 리커전이었다. 시작은 조금 묘하며 컴퓨터의 시작에도 관련이 있다.

조금 더 역사를 거슬러 올라가면 리스프라는 언어를 만든 매카시가 알론조 처치(Alonzo Church)의 제자였다. 처치는 미국의 수학자이자 논리학자였다. 처치의 제자 중에는 뛰어난 사람이 많았다. 컴퓨터의 시작이라고도 하는 앨런 튜링(Alan Turing)도 처치의 제자였다. Stephen Cole Kleene이나 John George Kemeny도 처치의 제자다.

컴퓨터의 시작인 수학적인 문제를 기계적으로 푸는 문제는 튜링에 의해 튜링 기계로 알려져 있다. 이것은 1936년 튜링이 발표한 "On Computable Numbers, with an Application of Entscheidungs Problem"이라는 애매한 제목의 논문에서 표면으로 나오게 되었다. 튜링은 당시 중요한 수학적 문제였던 entscheidungs problem에 태클을 건 것이다. 이 문제는 수학자 데이비드 힐버트가 1928년 제시한 것이다. 적어도 이론상으로 주어진 수학적 주장이 증명 가능한 것인지 판단할 수 있는 명확한 프로시저가 있는지에 대한 문제다. 이런 문제는 튜링과 같은 사람을 위한 문제로 증명의 답은 "그렇지 않다"는 것이었다. 처치 역시 같은 결론에 도달한 논문을 1936년에 발표했다. 프로시저의 기계화에 대해 눈이 뜨인 것이다.

프로시저라는 의미를 더 명백하게 하기 위해 튜링은 LCM(Logical Computing Machine)이라고 부르는 추상적인 기계를 발명했다. LCM은(다른 사람들은 튜링 머신이라고 불렀다) 명령과 데이터를 담은 종이테이프를 갖고 있고 테이프를 따라 움직이는 헤드가 정해진 규칙에 따라 명령을 읽고 해석하며 테이프에 새로운 것을 기록할 수 있는 기계다. 이런 종류의 기계는 진술한 내용의 진위를 테스트하는 프로시저를 따라할 수 있다. 같은 시기 프린스턴 대학에는 폰노이만도 있었다. 문제를 푸는 기계에 대한 튜링의 생각은 자연스럽게 일반적인 컴퓨팅 기계를 만드는 쪽으로 흘렀다. 튜링은 "Proposal for Deveolpment in the Mathematical Division of an Automatic Computing Engine"이라는 제안서를 영국의 국립 물리학 연구소(NPL)에 제출했다. 그 후 에니악(ENIAC)이 나오고 다시 폰노이만에 의해 프로그램 가능한 전자식 디지털 계산기가 나왔다.

그러나 처치가 같은 문제에 동원한 수단은 람다 계산법(lambda calculus)이었다. 람다 계산법 자체가 계산 가능한 함수를 다루는 것이므로 그 자체를 가장 단순한 범용 컴퓨터라고 생각할 수 있고 람다 계산법이 나온 지 20여 년이 지난 후에 매카시는 람다 계산법을 새로운 컴퓨터 언어에 도입할 것을 고려했다. 튜링 머신이 컴퓨터라는 기계에 영향을 주었다면 람다 계산법은 컴퓨터 언어에 영향을 주었다고 볼 수도 있다.

매카시의 유명한 글 "Recursive Functions of Symbolic Expressions and Their Computation by Machine"은 1960년 4월에 작성되었다. 그 이전에는 몇 개의 메모들과 편지들이 남아있다. 이 글이 바로 리스프의 시작이라고 봐도 좋다.

매카시의 아이디어는 MIT의 AI 연구소에서 허망할 정도로 빨리 하나의 프로그래밍 언어로 만들어졌다. 처음에는 종이에 적던 핸드 컴파일 수준의 작업이 하나의 아이디어로 만들어지고 그 다음에는 스티브 러셀에 의해 실제로 컴퓨터 프로그램으로 만들어진 것이다. 리스프는 이렇게 갑자기 만들어진 것이다. 람다 함수를 이야기하면 독자들이 질릴 것 같아서 실제로 리스프가 어떻게 구현되었는가를 보여주는 것이 재미있을 것 같다. 실제로는 SICP 4장에 나오는 내용을 아주 간단하게 미리 설명해보자는 것이다.

그렇다면 매카시가 만들었다는 리스프라는 것이 도대체 무엇인가. 매카시가 사용했다는 IBM 704가 없으니 오늘날의 PC로 만들어 보는 수밖에 없다. 실제로 폴 그레이엄이 이런 실험을 했다. 폴 그레이엄이 책에 수록하지는 않았으나 인터넷에서 볼 수 있는 The Roots of Lisp라는 글은 매카시가 쓴 논문을 오늘날 우리가 사용하는 커먼 리스프(Common LISP)로 구현한 것이다. 그것은 바로 원시적인 인터프리터가 얼마나 쉽게 구현될 수 있는지를 보여주는 것이다. 인쇄하면 A4 한 쪽도 안 되는 소스코드로 리스프 인터프리터가 구현될 수 있다(물론 기계어로 구현하는 것은 더 복잡하지만 불가능할 것도 없다. 파이썬이나 자바로도 리스프 인터프리터를 작성할 수 있다).

원시적인 인터프리터를 만드는 것은 정말 쉽다. 여기서 조금씩 덧붙이면 SICP의 인터프리터가 된다. 메타 서큘러 인터프리터라고 하는 것으로 리스프가 수행되는 기계가 있다면 리스프를 돌려보는 인터프리터로 귀착된다. 그리고 이 코드는 빈약하기 그지없던 1960년대의 하드웨어로도 잘 수행되던 코드다. 이 간단한 코드가 코드를 만들고 그 코드가 코드를 또 만들어낸 것이다. 인공지능의 복잡한 코드들도 간단한 인터프리터에서 시작된 것이다. 이 인터프리터의 모든 식은 일곱 개의 간단한 원시 연산자로 해결할 수 있다. 리스프의 식을 리스트로 표현하면 가장 먼저 나오는 식은 연산자(operator)이며 다른 요소는 인수(arguments) 또는 피연산자(operands)라고 생각할 수 있다. 연산자로 quote, atom, eq, car, cdr, cons, cond 를 사용할 수 있으면 원리적으로 리스프 인터프리터를 만들 수 있다.

(quote x)는x를 되돌리며'x와 같다.(atom x)는x가 아톰이라는 기본형의 원소이거나 빈 리스트이면t를, 아니면()를 되돌린다(t는 참을 의미하고()는 거짓을 의미하는 값이라고 하자).(eq x y)는x와y의 값이 같으면t를, 아니면()를 되돌린다.(car x)는 리스트x의 첫 값을 되돌린다.(cdr x)는 리스트x의 첫 값을 제외한 나머지 값을 되돌린다.(cons x y)는x로 시작하고 리스트y의 값들이 따라오는 리스트를 돌려준다.(cond (p1 e1) ... (pn en))은p1부터 시작하여p로 시작하는 식이 참이 나올 때까지 계산한다.- 만약 참이 나오면 해당하는 식

e를 전체cond의 값으로 되돌려준다.

이게 다인가? 다는 아니지만 이 연산자들만으로 인터프리터를 만들 수 있다. 다음 회에는 앞의 식들에 간단한 설명을 붙이고 진짜 인터프리터를 만들어 수행을 시켜보겠다.

Part2: 원시 리스프의 재구성

2007년 5월 8일

들어가며

리스프(LISP) 개발 초기 역사에 대해 중요한 문서는 매카시 자신의 History of LISP이며 다른 하나는 H.Stoyan이 정리해 놓은 리스프의 역사로 둘 다 매카시의 홈페이지(http://www-formal.stanford.edu/jmc/history)에서 찾아볼 수 있다.

History of LISP에서 매카시는 너무 가벼운 마음으로 일을 진행한 것을 한탄하고 있다. 튜링머신보다 리스프가 더 좋으려면 만능 리스프 함수가 있어야 하고 이 함수는 튜링머신으로 적는 것보다 더 깔끔하고 이해하기 쉬워야 했다. 이것이 바로 리스프 함수 eval[e, a] 이었다. 여기서 e 는 리스프 식이며, a 는 변수에 적어 넣을 값을 가지고 있는 리스트다. 매카시는 eval 을 만들면서 리스프 함수를 데이터처럼 나타내는 방법을 만들어야 했고 이 표기법은 표기를 위한 목적으로 생각했을 뿐 실제로 리스프 프로그램을 위해 사용되리라고는 생각하지 못했다. 매카시가 함수 eval 을 구현하기 위해 그리고 새로운 언어를 위해 할 일은 많았다. 일의 중요한 진척의 하나로 함수가 함수의 인자로서 사용될 수 있는 표기법을 논리적으로 완결하는 일도 필요했다. 매카시가 만든 일들 가운데에는 원래의 람다(lamda) 표기법에 없었던 것들도 있었다. 이를테면 Label 표기법 같은 것들이다.

Stoyan의 문서는 매카시의 리스프 문헌을 중심으로 재구성한 것이다. The Influence of the Designer on the Design -- J.McCarthy and Lisp라는 제목으로 찾아볼 수 있다.

지난 회에 설명한 리스프의 기본적인 논문은 매카시가 쓴 Recursive Functions of Symbolic Expressions and their Computation by Machine의 Part 1이었다(Part 2는 끝내 나오지 않았다). 이 글은 지금 봐도 참신함을 잃지 않을 정도로 잘 정리된 글이다. 몇 년에 걸쳐 다듬고 매만진 글이기 때문인지도 모른다.

매카시는 이 글과 그 전의 아이디어를 조수에게 보여주었다. 글을 읽던 매카시의 대학원생이었던 스티프 러셀(Steve Russel)은 예상보다 총명했다. 러셀은 eval 함수가 리스프의 인터프리터로 사용될 수 있다는 것을 깨달았다. 결국 리스프를 IBM 704에서 구현했다(나중에 Space War라는 첫 번째 컴퓨터게임을 만들기도 한다).

컴퓨터로 프로그래밍과 디버깅을 거듭하자 무엇인가가 나왔다. 그리고 사람들은 인터프리터로 만든 언어를 갖게 되었다. 갑자기 리스프가 구현된 것이다. 인터프리터가 예상치 못하게 빠르게 나옴에 따라 언어의 형태가 갑작스럽게 초기 상태에서 고정되었고 원래의 논문 'Recursive Function...'에서 별생각 없이 만든 결정들이 언어의 요소가 되었다. 그중에는 나중에 별로 좋은 생각이 아니었다는 것으로 밝혀진 것들도 있었으나 대부분은 그대로 살아남았다. 그만큼 리스프는 빠르게 수용되었다. 그리고 매카시 자신이 리스프가 가능한 것이라고 믿었던 것이 아니기 때문에 리스프를 발명한 것이 아니라 발견했다고도 말한다.

매카시는 History of LISP에서 당시 자신이 람다함수에 대해 알기는 했지만 불완전하게 이해하고 있었다는 사실도 인정했다. 처음에 리스프는 람다함수의 불완전한 표기법을 채택하고 있었고 점차 완전한 것으로 변해갔다. 이미 리스프가 만들어진 상태에서 매카시는 몇 가지를 고쳐보려고 했지만 때는 늦었다. 리스프를 실제로 사용하는 사람들과 리스프를 만든 매카시의 생각의 차이가 커져갔고 사용자 그룹의 힘이 더 커져감에 따라 매카시는 언어에 대한 통제를 포기하고 자신의 주제로 돌아가 버렸다. 하지만 리스프를 만든 것은 분명 매카시였다.

리스프 인터프리터의 구현

이번 회의 주제는 'Recursive Functions ...'을 폴 그레이엄이 요즘의 리스프로 다시 구성한 것을 설명하는 것이다. 즉 리스프의 재구성이다. 50년이 다 되어가는 옛날 리스프를 다시 구현해 본다는 것이 이상하기는 하지만 인터프리터를 살펴보는 일이 리스프를 이해하는 가장 좋은 방법이며 전통적인 방법이다.

리스프 개발은 사람들이 원시적인 인터프리터를 만들고 그 위에 다른 리스프를 구현하며 발전했다. 사실 리스프의 역사에는 어떤 리스프 인터프리터 위에 다른 리스프가 올라가고 또 다른 것이 그 개량판 위에 올라간 역사가 있다. 얼마나 복잡한 층위를 만들었는지는 아무도 모른다. 이런 방식의 인터프리터를 메타서큘러 인터프리터라고 한다. 처음엔 해커들은 자신의 리스프를 만들었고(라이브러리보다 언어를 만드는 편이 더 빨랐다. 간단했기 때문이다) 이들 중에서 남는 것은 점차 줄어들었다. 아무래도 효과적인 구현들만이 남았기 때문이다. 결국에는 몇 개로 줄어들었다. 하지만 요즘도 리스프 교재에서 메타서큘러 인터프리터를 만드는 일은 중요한 단계로 남아있다. 언어 자체의 이해가 증가하기 때문이다. SICP는 4장 전체를 인터프리터에 바치고 있다.

맨 처음 나온 리스프 인터프리터는 스티브 러셀이 IBM 704에 만든 구현이다. 그 구현은 펀치카드 방식의 IBM 704를 손으로 어셈블하면서 만들어졌고 당시의 자료들 또한 남아있다. 러셀은 나중에 엄청나게 번거로운 작업이었다고 회고했다. 펀치카드로 작업하는 배치 방식 코딩과 디버깅은 쉬운 일이 아니다.

얼마 후 리스프는 DEC의 PDP-1 컴퓨터로 이식되었다. PDP-1의 인터랙티브한 환경에서 리스프가 돌아간다는 것이 알려지자 곧바로 컴퓨터에 빠져 사는 사람들이 나오게 되었다. 이들이 바로 해커들이다. 해커리즘의 근본적인 도구는 매카시의 논문을 스티브 러셀이 작업(해킹)하여 탄생했고 DEC 초기 기계들을 중심으로 MIT에서 해커들이 해킹하는(다듬는) 형태를 통해 발전했다. 스탠포드나 BBN 같은 회사들에서도 중요한 리스프 변종들이 나오기 시작했다.

매카시에게 기계적 지능 구현을 위해 가장 중요한 것은 포멀리즘(형식주의)이었다. 수학의 형식을 빌어 알고리즘으로 문제를 푸는 일은 문제를 기계가 풀 수 있는 형식(표기법)과 기능을 만드는 일이다. 리스프는 중요한 진보였다. 동일하지는 않지만 처치의 람다 계산법을 사용하여 범용의 튜링머신을 만들어 낸 것이기 때문이다. 포멀리즘은 기계가 다룰 수 있는 형태로 표현할 수 있다면 기계가 반복적인 계산을 되풀이하여 정확한 답을 줄 수 있기 때문에 형식과 형식의 체계는 매우 중요하다. 또 이 형식주의는 사람 손으로 문제를 푸는 것보다는 기계에 더 적합한 형태의 연산이라는 것이 매카시의 생각이었다. 정확한 형식으로 표현할 수 있다면 기계가 못 풀 문제도 없다는 것이다.

초기 인공지능은 이렇게 소박한 기반 위에서 출발했다. 물론 기계가 풀 수 있을 정도로 간단한 형식으로 바꾸는 것이 쉽지 않다는 것을 발견하는 과정이 곧 뒤따랐다. 매카시가 차용한 람다 계산법이라는 것은 일종의 일반화된 함수의 치환으로 생각할 수 있다. 그런데 이 간단한 치환으로 많은 것들을 할 수 있다. 기호와 기호 표기의 포멀리즘이 지배하는 곳에서는 더욱 그렇다. 기계적으로 기호를 치환하는 것으로 아주 많은 일을 할 수 있다. 인공지능도 그런 일들 가운데 하나다.

인공지능의 또 다른 개척자 마빈 민스키는 프로그래밍의 다른 측면을 보았다. 앞으로 필요한 인공지능과 관련하여 프로그램들의 개발이 많이 필요할 것이며 이 프로그램들은 컴퓨터에 빠져있는 해커들이 아니면 만들어낼 수 없다는 것을 본 것이다. 민스키는 학자들의 엘리트주의나 권위주의적인 기업의 기술 문화가 아닌 해커 문화의 일면을 보았다. 해커들의 지성의 다른 측면이었다.

민스키는 자유방임적인 놀이터의 주인 역할을 자처했다. MIT의 인공지능 연구소에 투입된 자금과 장비를 이용해 해커들을 고용하고 이들이 마음껏 프로그래밍을 할 수 있는 환경을 만들었다. 해커들은 대학원생 출신이거나 다른 곳에서 들어오기도 했다, 급료는 높지 않았다. 오로지 해킹이라는 일 자체가 목표였고 컴퓨터를 마음대로 쓰는 것으로 동기는 충분히 높았다고 전한다. 이런 것들을 좋아하는 사람들에게 장난감을 던져주고 그들이 원하는 것을 하게 내버려두는 것이 민스키의 아이디어였다. 당시의 인공지능 연구소에는 할 일이 많았다. 이 놀이터에서 해커들은 마법사로 볼 수 있고 착한 놀이터 주인인 민스키가 부탁을 하면 무엇이든지 만들어 주곤 했다.

다만 해커들의 놀이에는 스스로 정한 엄격한 문화와 기준이 있었다. 당시로서는 이런 놀이터는 인공지능 연구소가 유일했다. 이들의 개성과 배경은 모두 달랐다. 이윽고 특이한 문화가 탄생했다. 그 특징의 하나인 강한 개성과 자유, 그리고 이들과 양립하는 고도의 지성이 있었다. 스티븐 레비의 『해커』라는 책은 당시의 분위기를 전한다. 이런 분위기를 유지하는 것이 얼마나 어려운가를 상상하는 것은 오늘날에도 어렵지 않다. 1960년대에는 요즘보다 더 어려운 일이었지만 해커들의 놀이터는 실제로 여러 해 동안 존재했고 고도의 지적 기준과 심미안, 몰입과 창조의 와중에서 프로그램들과 문화가 태동했다. 스티븐 레비에 의하면 이런 일들은 결국은 해커들의 자기 표현이었다. 일종의 창조적 예술이라고 본 것이다.

말이 길어졌지만 그 때 이들이 진지하게 사용했던 언어는 리스프였다. 지금으로 보면 초라한 하드웨어를 가지고 해커들은 이 리스프로 인공지능 연구소에서 원하던 것들을 (거의) 무엇이든지 만들어 주는 마술을 부렸다. 인공지능의 유명한 프로그램들이 빈약한 기계에서 리스프로 만들어졌다. 당시에는 뛰어난 사람들이 리스프에 빠져 있었고 리스프를 바탕으로 만든 언어들도 많으며 리스프에서 많은 영감을 받기도 했다. 리스프는 처음부터 언어라기보다는 수학적 표현이나 알고리즘에 더 가까웠던 것이다.

구현하기 전에 고려할 것들

이번 회의 주제가 매카시의 'Recursive Function ...'을 이해하는 것이므로 다시 원래 주제로 돌아가 보자. 지난 글은 7개의 기본 연산자를 만드는 것으로 끝났다. 정말 이 7개의 식으로 인터프리터를 만들 수 있을까? 이것이 이번 주제다. 답은 미리 말했듯이 "만들 수 있다"이다.

문제는 리스프에 접할 기회가 적었기 때문에 관심이 있다고 해도 리스프를 전혀 모르면 설명이 애매하다고 느낄 수 있는 부분이 있어 여기에 대해 약간의 보충 설명이 필요할 수 있다. 보충 설명을 위해 『A Gentle Introduction to Symbolic Computation』 이라는 훌륭한 책이 있다. 책의 앞부분을 읽고 그림을 보고 있으면 보조 자료로 충분하다. 하지만 필자는 가급적 설명을 쉽게 하려고 애쓸 것이다. Peter Siebel의 『Practical Common LISP』도 쉽게 읽을 수 있는 책이다. 이 정도면 역시 충분할 것이다.

그리고 리스프를 실행할 수 있는 적당한 환경이 있어야 한다. 요즘은 LispWorks나 Franz Lisp 같은 곳에서 윈도우와 리눅스용 리스프를 다운로드할 수 있으므로 문제가 될 것이 없다. 그 외에도 많은 리스프 구현이 있으며 소스까지 공개된 것들도 있다. 하지만 이번 설명에서 반드시 리스프가 필요한 것은 아니다. 종이와 연필로도 풀어볼 수 있다.

리스프에서 식(expression)이 리스트일 때 첫 번째 요소가 연산자(operator)이면 나머지 요소들은 인자(argument)로 작용한다. 이를테면 2+3은 (+ 2 3) 으로 표시한다. 연산자는 + 이고 2 와 3 은 인자인 것이다. 먼저 지난번에 설명한 7개의 연산자를 다시 적어 보자.

(quote x)는x를 되돌리며'x와 같다.(atom x)는x가 아톰이라는 기본형의 원소이거나 빈 리스트이면t를, 아니면()를 되돌린다(t는 참을 의미하고()는 거짓을 의미하는 값이라고 하자).(eq x y)는x와y의 값이 같으면t를, 아니면()를 되돌린다.(car x)는 리스트x의 첫 값을 되돌린다.(cdr x)는 리스트x의 첫 값을 제외한 나머지 값을 되돌린다.(cons x y)는x로 시작하고 리스트y의 값들이 따라오는 리스트를 돌려준다.(cond (p1 e1) ... (pn en))은p1부터 시작하여p로 시작하는 식이 참이 나올 때까지 계산한다. 만약pi에서 참이 나오면 해당하는 식ei를 전체cond의 값으로 되돌려준다. 끝까지 참이 나오지 않으면 빈 리스트를 되돌린다.

먼저 2번의 atom 이라는 연산자를 살펴보자. 리스프에서 어떤 식이 atom 이라는 것은 리스트가 아니라는 것을 의미한다. 기호 아톰(atomic symbol)은 어떤 기호가 atom 의 성질을 갖는다는 것을 의미한다. 또한 리스프의 S-식(S-Expression)을 다음과 같이 정의한다. 우선 S-식의 표현을 리스프에서 의미를 부여한 기호인 ( . ) 를 사용하여 나타내기로 하자.

- 기호 아톰은 S-식이다.

- 만약

e1과e2가 S-식이라면(e1 . e2)도 S-식이다.

정의는 A, B, AB 와 같은 기호는 당연히 S-식이다. 그러므로 정의 2에 의해 (A . B) 도 S-식이며 ((AB . C) . D) 도 기호식이다. 그러므로 리스프에서는 기호 아톰과 리스트 두 종류의 S-식 형태만이 존재한다. 따라서 (atom x) 가 참이면 x는 리스트가 아닌 S-식, 바로 기호 아톰이다.

이제는 4, 5, 6번을 조금 자세히 살펴보자. 이들은 리스트를 만들고 리스트를 조작하는 핵심적인 기능을 한다. 리스프가 LISt Processing이라는 것을 생각하면 핵심적인 조작이다. 모든 일들은 CONS 셀(Construct Cell)이라는 자료구조를 중심으로 일어난다.

그림 1. cons 셀

그림 1. cons 셀

CONS 셀의 왼쪽은 CAR라고 부르며 오른쪽은 CDR이라고 부른다. 리스트 구조와 리스트로 나타내는 식의 의미는 매카시의 'Recursive Function...'를 보아야 할 것이나 여기서는 이것으로 충분하다(초기 IBM 704와 그 후속 기종은 36비트로 15비트씩을 CAR와 CDR에 할당했다. CAR와 CDR은 어셈블러의 매크로 함수 이름이었다고 한다).

가장 기본적인 식은 CONS다. CONS는 두 개의 인자를 취해 이들을 연결한다. 그래서 (cons 1 2) 는 (1 . 2) 를 리턴한다. 앞의 cons 셀에서 car는 1 이고 cdr은 2 이다. 따라서 다음과 같은 식이 가능하다.

(car (cons 1 2)) ==> 1

(cdr (cons 1 2)) ==> 2리스트는 다음과 같이 표현된다. 이를테면 3개의 요소로 구성된 리스트 (1 2 3) 이 있다고 하자. 그러면 이 리스트의 실제 모양은 아래 그림과 같다.

>

>

그림 2. 리스트 (1 2 3)

(1 2 3) 을 만들고 조작하는 방법은 재귀적이다.

(cons 1 (cons 2 (cons 3 nil))) ==> (1 2 3)위 식의 car를 구하면 다음과 같다.

(car (cons 1 (cons 2 (cons 3 nil))) ) ==> (car (1 2 3))==> 1그림에서 상상할 수 있듯이 리스트 (1 2 3) 의 car는 1 이다. (1 2 3) 의 cdr을 구하면 다음과 같다.

(cdr (cons 1 (cons 2 (cons 3 nil))) ) ==> (cons 2 (cons 3 nil)) ==>(2 3)첫 번째 박스의 CDR이 가리키는 포인터는 2와 3의 리스트인 것이다. 앞 식의 car를 다시 구한다면 다음과 같다.

(car (cdr (cons 1 (cons 2 (cons 3 nil))) )) ==> (car (2 3)) ==> 2이런 식으로 문제를 해결한다. 함수형 스타일(functional style)이다. 이보다 더 복잡한 것들도 재귀를 이용한 함수형 방식으로 처리할 수 있고 인터프리터가 만들어내는 복잡한 치환도 마찬가지다. 복사도 할 수 있고 리스트를 뒤집을 수도 있다. 리스트 안의 리스트와 같은 중첩된 표현도 가능하다. 위의 car와 cdr의 조합들은 많이 사용되는 것들이라 아래와 같은 표기법으로 사용되기도 한다.

(caar list) === (car (car list))

(cadr list) === (car (cdr list))

(cadadr list) === (car (cdr (car (cdr list))))Root of LISP에 나오는 리스트 예제들도 간단하다.

(car '(a b c)) ==> a

(cdr '(a b c)) ==> (b c)

(cons 'a '(b c)) ==> (a b c)

(cons 'a (cons 'b (cons 'c '()))) ==> (a b c)

(car (cons 'a '(b c))) ==> a

(cdr (cons 'a '(b c))) ==> (b c)마찬가지로 다음과 같다.

(cadr '((a b) (c d) e)) ==> (c d)

(caddr '((a b) (c d) e)) ==> e

(cdar '((a b) (c d) e)) ==> (b)하나 더 남아있다. list라는 연산자를 이용하는 것이다. (list e1 ... en) 은 결국 (cons e1 ... (cons en '()) ... ) 과 같은 형식이다. 예를 들면 아래의 두 식은 같은 값을 되돌려준다.

(cons 'a (cons 'b (cons 'c '()))) ==> (a b c)

(list 'a 'b 'c) ==> (a b c)아직까지는 특별히 이해에 어려울 것이 없는 것 같다. 7번의 cond 도 간단하다. (cond (p1 e1) ... (pn en)) 은 p 라는 술어(predicate)를 차례로 계산하여 참이 나올 때까지 계산하고 참이 나오면 pi 에 대한 ei 를 계산하여 되돌린다. 만약 참이 나오지 않으면 '() 를 되돌린다(빈 리스트 '() 를 일단 false 로 생각하자). 매카시의 책에서는 (p1 -> e1, ... , pn -> en) 으로 표기했다. 예를 들면 (1 < 2 -> 4, 1 > 2 ->3) 은 4 를 되돌린다.

리스프에서도 다음과 같은 예제를 보면 별다른 것이 없다. 'a 와 'b 가 같지 않으므로 두 번째 술어부를 계산하고 'a 가 atom이므로 second 가 나온 것이다. 만약 'a 가 atom이 아니었으면 두 번째 술어부도 참이 아니므로 끝에 도달하여 '() 를 리턴하였을 것이다.

(cond ((eq 'a 'b) 'first) ((atom 'a) 'second)) ==> second위의 연산자 중에서 quote 와 cond 를 제외하고 나머지는 먼저 연산자가 계산되고 나서 인자들이 계산된다. 이런 연산자를 함수(function)라고 부른다. 함수 표기법에 대해 매카시의 의견은 매우 간단했다(요즘은 당연히 여겨지는 것이 당시엔 나름대로 중요한 결정이었다).

사람들이 y2+x 와 같은 form을 함수와 구별 없이 사용하는 경향이 있는데 알론조 처치는 앞의 식을 form 이라고 불렀고 form 이 함수가 되려면 인자들의 값이 form 에서 어떤 값과 일치하는지 알 수 있어야 한다는 것이다. 처치가 고안한 표기법은 E가 form이라고 할 때 ((x1 ... xn), E) 로 표기하면 인수의 차례는 x1 에서 xn 까지 일치해야 한다는 것이다. 람다는 일단 이런 표기법이라고 할 수 있다.

리스프에서 함수는 (lambda (p1 ... pn ) e) 로 표시하며 p 1 ... pn 은 인자(parameters)이고 e 는 식이다. 함수 호출(function call)의 일반적 형태는 다음과 같다.

((lambda (p1... pn ) e) a1 ... an)여기서 a1 ... an 의 식들을 모두 계산하고 난 후 식 e 를 계산한다. e 식을 계산할 때 pi 는 해당하는 계산된 ai 의 값과 일치한다. a1 부터 an 까지를 모두 계산하여 적용시키기 때문에 값을 전하는 것이다(call by value). 이름이나 포인터만을 전하는 것과 다르다(call by name). 이 문제는 나중에 다시 논의하게 되며 일단 CBV 방법만을 사용한다고 가정하자. 그러면 모두 계산을 해서 값만을 e 에 전달한다는 의미다. 간단한 예를 들면 다음과 같다.

((lambda (x y) (+ (* y y) x) 3 4) ==> 19여기서 y2+x 가 인자에 맞추어 계산되었다.

((lambda (x) (cons x '(b))) 'a) ==> (a b)위 식에서 인자는 'a 이고 리스트 '(b) 와 함께 cons 가 적용되었다. 람다를 설명했으니 이제 label을 설명할 차례다.

(label f (lambda (p1 ... pn) e)) 로 표기하는 것은 함수 (lambda (p1 ... pn) e) 로 표기하는 것에 대해 e 안에 f 가 나타나는 경우 f 는 label 이하의 식으로 계산된다. 이 방식은 N. Rochester가 고안하고 매카시가 채용한 것이다. 처치의 람다로 계산하는 것보다는 간단했다고 한다. 일반적으로 label 보다는 defun 으로 더 많이 사용한다. 그러니까 (defun f (p1 ... pn) e) 라고 쓰는 일이 더 많은 것이다. 람다 함수에 이름이 붙었다고 생각하면 된다.

이제 앞에 나온 식을 바탕으로 몇 개의 함수를 정의해 보자. 여기서 함수 뒤에 점(null 이 아니라 null. 처럼)을 붙인 것은 파생된 함수를 나타내기 위해서다. 기본적인 7개의 식은 이미 앞에서 설명했다.

;; 1. (null. x)는 x가 빈 리스트인지를 검사한다.

(defun null. (x)

(eq x '()))

(null. 'a ) ==> ()

(null. '()) ==> t

;; 2. (and. x y)는 두 인수가 참이면 t를 아니면 ()를 돌려준다.

(defun and. (x y)

(cond (x (cond (y 't) ('t '())))

('t '())))

(and. (atom 'a) (eq 'a 'a)) ==> t

(and. (atom 'a) (eq 'a 'b)) ==> ()

;; 3. (not. x) 만약 인수가 ()를 돌려주면 t를, 인수가 t를 돌려주면 ()를 돌려준다.

(defun not. (x)

(cond (x '())

('t 't)))

(not (eq 'a 'a)) ==> ()

(not (eq 'a 'b)) ==> t

;; 4. (append. x y)는 두 리스트를 취하고 이들을 연결하여 돌려준다.

(defun append. (x y)

(cond ((null. x) y)

('t (cons (car x) (append. (cdr x) y)))))

(append. '(a b) '(c d)) ==> (a b c d)

(append. '() '(c d)) ==> (c d)

;; 5. (pair. x y)는 길이가 같은 두 리스트를 받아 이들로부터 차례로 리스트의 각

;; 원소를 취한 쌍의 리스트를 돌려준다.

(defun pair. (x y)

(cond ((and. (null. x) (null. y)) '())

((and. (not. (atom x)) (not. (atom y)))

(cons (list (car x) (car y))

(pair. (cdr x) (cdr y))))))

;; 복잡해 보이지만 실제의 동작은 간단하다.

(pair. '(x y z) '(a b c)) ==> ((x a) (y b) (z c))

;; 6. (assoc. x y)은 아톰 x와 pair로 만든 리스트 y를 받아 쌍의 첫 원소가 x와

;; 동일한 리스트의 두 번째 원소를 돌려준다.

(defun assoc. (x y)

(cond ((eq (caar y) x) (cadar y))

('t (assoc. x (cdr y)))))

(assoc. 'x '((x a) (y b))) ==> a

(assoc. 'x '((x new) (x a) (y b))) ==> new1부터 6은 매카시의 글에 나오는 식들을 실제의 리스프로 변환한 것들이다.

리스프 인터프리터의 핵심, eval

이제 여기까지 왔으니 eval 의 소스를 구경할 차례다. 앞에서 말한 것처럼 eval 의 소스 코드는 a4 한 페이지 정도 분량에 지나지 않는다. 리스프 인터프리터에서 eval 은 핵심 그 자체로 식을 계산(evaluate)하여 결과를 돌려주는 일을 한다. 식에서 'eval.', 'evcon.', 'evlis.'처럼 점이 붙어있는 함수는 기본 연산자를 바탕으로 파생된 함수라는 것을 알려준다.

(defun eval. (e a)

(cond

((atom e) (assoc. e a))

((atom (car e))

(cond

((eq (car e) 'quote) (cadr e))

((eq (car e) 'atom) (atom (eval. (cadr e) a)))

((eq (car e) 'eq) (eq (eval. (cadr e) a)

(eval. (caddr e) a)))

((eq (car e) 'car) (car (eval. (cadr e) a)))

((eq (car e) 'cdr) (cdr (eval. (cadr e) a)))

((eq (car e) 'cons) (cons (eval. (cadr e) a)

(eval. (caddr e) a)))

((eq (car e) 'cond) (evcon. (cdr e) a))

('t (eval. (cons (assoc. (car e) a)

(cdr e))

a))))

((eq (caar e) 'label)

(eval. (cons (caddar e) (cdr e))

(cons (list. (cadar e) (car e)) a)))

((eq (caar e) 'lambda)

(eval. (caddar e)

(append. (pair. (cadar e) (evlis. (cdr e) a))

a)))))

(defun evcon. (c a)

(cond ((eval. (caar c) a)

(eval. (cadar c) a))

('t (evcon. (cdr c) a))))

(defun evlis. (m a)

(cond ((null. m) '())

('t (cons (eval. (car m) a)

(evlis. (cdr m) a)))))이 식을 돌려보기로 하자. eval 함수는 두 개의 인수를 갖는다. eval. (e a) 에서 계산하려는 식 e 와 함수 호출에서 atom 에 부여할 값을 부여하는 a 라는 리스트다. a 는 환경(environment)이라고도 부른다. 이 환경은 나중에 나오는 environment model과는 조금 다르다. 환경의 값은 pair 를 이용하여 쌍으로 만들어 내며 값을 찾기 위해서는 assoc 을 이용한다. eval 은 4개의 cond 항목으로 이루어져 있다.

- 우선 식

e가atom인 경우의eval.의 동작을 보자. 식e는 그냥x이고 환경은'((x a) (y b))다.cond는assoc.을 이용하여a를 되돌린다.

(eval. 'x '((x a) (y b))) ==> a- 두 번째는

e가(a ...)와 같은 형태의 식으로a는atom이다, 그리고 이 경우는 앞에서 설명한 7개의 기본 연산자를 모두 사용하는 경우이며 다시cond로 각 연산자별로 분기한다.

(eval. '(eq 'a 'a) '()) ==> t

(eval. '(cons x '(b c))

'((x a) (y b))) ==> (a b c)quote 를 제외한 나머지는 모두 다시 eval 을 호출하여 인자의 값을 계산한다.

생각해보면 결국 인자를 모두 계산하여 6개의 기본 연산자에 대입하는 것으로 귀착된다. cond 는 조금 더 복잡하다. cond 를 계산하려면 evcon 이라는 다른 함수를 불러야 한다. 이 함수는 재귀적으로 식의 요소를 평가하여 첫 번째 t 가 나오면 술어 다음의 식을 계산한다. t 가 나오는 술어가 없다면 '() 를 리턴한다. evcon 함수는 cond 리스트의 처음부터 eval. 하여 참이 나오면 그 술어와 쌍이 되는 식을 eval. 하여 돌려준다.

(eval. '(cond ((atom x) 'atom) ('t 'list)) '((x '(a b)))) ==> list그리고 두 번째 절의 마지막은 매개변수처럼 전달된 함수 호출을 다루는 것으로 아톰을 해당 값으로 치환하는 것이다. 이들은 lambda 나 label 을 이용하며 그 값이 다시 계산된다.

(eval. '(f '(b c))

'((f (lambda (x) (cons 'a x)))))

==>

(eval. '((lambda (x) (cons 'a x)) '(b c))

'((f (lambda (x) (cons 'a x))))) ==> (a b c)위의 식에서 f는 환경에서 발견되어 (lambda (x) (cons 'a x)) 로 치환되었다.

- 그 다음은

label이다.label의 식은 매우 복잡하지만label이 하는 일은 결국 환경a에label함수의 이름과 해당lambda를 더하는 것이다. 그래서 다음과 같다.

(eval. '((label firstatom (lambda (x)

(cond ((atom x) x)

('t (firstatom (car x))))))

y)

'((y ((a b) (c d)))))

==>

(eval. '((lambda (x)

(cond ((atom x) x)

('t (firstatom (car x)))))

y)

'((firstatom

(label firstatom (lambda (x)

(cond ((atom x) x)

('t (firstatom (car x)))))))

(y ((a b) (c d)))))결국 이 식은 환경 a 에 firstatom 의 람다 식을 추가한 것이다(너무 복잡하게 생각하면 안 된다). 결국 계산이 일어나면 a 를 리턴한다.

- 그 다음은

lambda다.((lambda (p1 … pn ) e) a1 … an)은evlis를 불러서a1 ... an의 인자들을 계산한다. 그 다음에 이 계산 값(v1 ... vn)이a1 ... an과 쌍을 만들게 되어(a1 v1) ... (an vn)의 리스트가 환경의 앞에 추가되는 형태가 된다.

(eval. '((lambda (x y) (cons x (cdr y)))

'a

'(b c d))

'())

==>

(eval. '(cons x (cdr y))

'((x a) (y (b c d))))위의 식에서 x 와 y 의 값이 쌍으로 주어졌다. lambda 의 인자 리스트는 환경변수로 계산되어 바뀐 것이다(대단히 중요한 결론이다. 리스프 인터프리터는 인자 리스트를 계산하여 환경에 보관한다. 그리고 연산자만 남고 인자 리스트는 없어진다). 결국 계산은 (a c d) 를 되돌린다.

위의 eval. 은 매카시의 글에 나온 식을 그레이엄이 리스프로 번역한 것들이고 필자는 두 개의 문서를 놓고 비교했다. 그레이엄의 프로그램에서 apply 가 보이지 않기 때문에 리스프 인터프리터에 대해 배운 독자들은 이상하다고 생각할지 모른다. 그러나 최초의 리스프 인터프리터 구현은 요즘의 인터프리터와 apply 와 eval 의 순서가 반대다. 글에서 매카시는 apply 를 universal function으로 보았다. 매카시의 리스프에서 apply 는 각 인자에 대해 quote 를 붙이기 위해 사용되었다. 시작이 되고 나면 모두 eval 이 처리한다(일반적으로 apply 가 적용되는 곳이 위 식에서= evlis.= 가 적용되는 부분이다).

역사적인 이유로 매카시가 생각한 용법의 apply 도 적어본다.

apply[f;args] = eval[cons[f;appq[args]];NIL]

appq[m] = [null[m] -> NIL;

T -> cons[list[QUOTE;car[m]];appq[cdr[m]]]]

eval [ ]

[...

...

]끝으로

이게 다인가? 다는 아니지만 핵심이라고 말할 수 있다. 요즘의 리스프에서 몇 개 빠진 부분은 있으나 중요한 부분은 모두 망라한다.

메타서큘러 인터프리터는 상당히 중요하므로 매카시 본인이 만든 인터프리터도 있다. 매카시 자신이 만든 "A Micro-Manual for Lisp -- not the whole Truth"라는 글이 이런 내용으로 2페이지짜리 글을 인터넷에서 다운로드할 수 있다.

이번에 설명한 eval. 은 SICP의 강의 비디오 7a에서 서스만이 "모든 언어의 커널(The Kernel of Every Language)" 또는 "The Spirit in the computer"이라고 부르는 것이다. 몇 개의 식만 잘 정의하면 일단 돌아갈 수 있는 인터프리터가 나온다는 것, 이것이 바로 비밀이다. 나중에 이르기까지 인터프리터는 이것보다 조금 더 복잡해졌을 뿐이다. 앞의 프로그램에서 빠진 중요한 문제가 몇 개가 있으며 환경변수의 문제 같은 것이 있다. 이들은 SICP에서 모두 설명된다. The Art of Interpreter의 내용은 당연히 반영되었다.

이렇게 간신히 돌아가기 시작한 언어를 컴퓨터에 입력하고 종이에 식을 적은 후 검증을 하던 것이 1세대 해커들의 일이었다, 하지만 잘 돌아갔다.

리스프에서 모든 것은 리스트다. 프로그램도 데이터도 리스트이며 이것을 처리하는 인터프리터도 리스트이다. 만약 이런 것들을 일일이 손으로 계산한다면 고역이겠으나 다행히 컴퓨터가 있다.

정신없이 설명하다보니 독자들은 SICP의 4장을 미리 연습한 셈이 되고 말았다. 그리고 리스프가 구현되던 당시의 상황과 리스프라는 언어의 핵심을 한꺼번에 본 셈이다. 기왕 여기까지 왔으니 SICP나 다른 리스프 책을 보아도 좋을 것이다. 만약 리스프의 장점에 대해 조금 더 고무적인 글을 읽고 싶다면 폴 그레이엄의 『해커와 화가』와 같은 책이 있다. 책에서 리스프의 어떤 점이 중요하며 왜 좋은가에 대해 명쾌하게 설명하고 있다.

정신없이 설명하다보니 독자들은 SICP의 4장을 미리 연습한 셈이 되고 말았다. 그리고 리스프가 구현되던 당시의 상황과 리스프라는 언어의 핵심을 한꺼번에 본 셈이다. 기왕 여기까지 왔으니 SICP나 다른 리스프 책을 보아도 좋을 것이다. 만약 리스프의 장점에 대해 조금 더 고무적인 글을 읽고 싶다면 폴 그레이엄의 『해커와 화가』와 같은 책이 있다. 책에서 리스프의 어떤 점이 중요하며 왜 좋은가에 대해 명쾌하게 설명하고 있다.

Part3: 해커리즘의 문화

2007년 6월 5일

들어가며

누가 무언가를 아주 좋아한다고 생각해 보자. 그리고 그 일이 컴퓨터나 프로그래밍에 관한 것이라고 범위를 더 좁혀보자. 예술 또는 다른 분야의 일이나 취미라도 상관은 없다. 그리고 그 일에 지속적으로 몰입하는 사람들이 몇 명 더 있다고 하자. 여기에서 공통적인 문화가 하나 탄생한다. 일종의 하위문화(subculture)라고 할 수도 있는 이 문화는 그것이 어떤 것이건 빠져있는 사람들에게는 아주 진지한 것이다. 보는 각도에 따라 진지한 놀이처럼, 때로는 진지한 일처럼 보일 수도 있다(일과 놀이의 심리적 요소가 아주 비슷하다는 사실은 예전부터 알려져 왔었다).

만약 이 문화가 주류 문화라면 우리가 매일 열심히 일하는 세상 일이 된다(일상적인 세상 일이 아주 재미있는 경우는 흔치 않지만). 주류 세계와는 조금 다른 일이 더 재미있을 수도 있다. 비주류나 반문화적인 요소가 있는 문화가 수용되는 일도 꽤 많이 존재했다.

현재 IT 문화의 일부 역시 기묘한 하위문화로부터 출발했다. 해커리즘도 그 중 하나다. 당연히 초창기에는 컴퓨터를 만지는 사람들이 이상하게 보이거나 이단적으로 보였다. 그것도 (대기업이나 연구소 직원으로서가 아니라) 정말로 컴퓨터가 좋아 컴퓨터에 빠져든 사람들은 사회의 일반적인 시각에서 보면 분명히 이단적인 요소가 있었다.

스티븐 레비의 책 『해커 그 광기와 비밀의 기록(원제는 Hackers: Heroes of the Computer Revolution)』은 이러한 이야기를 풀어나갔다. 초창기 MIT AI 연구소를 중심으로 한 1세대 해커와 컴퓨터를 사람들에게 보급시킨 2세대 해커들의 이야기가 책의 3분의 2를 채우고 있다. 1세대 해커가 리스프(LISP) 해커와 미니컴퓨터 해커라면 빌 게이츠나 스티브 잡스 같은 문화 아이콘들은 2세대 해커에 속한다.

『해커…』라는 책이 나온 지 이미 20년 정도가 지났고 컴퓨터가 하나의 주류 문화 정도가 아니라 문명의 근간이 되면서 이런 사람들의 이야기가 수용되기 시작했다. 세월이 더 지나면 이야기를 아름답게 적을 수 있는 동화작가의 손을 거쳐 미화되어야 할지 모른다. 사람들이 기대하는 문화코드는 보통 그런 것들이고 그런 책들이 서점에서 잘 팔린다. 나중에 아이들에게 이야기해줄 때도 껄끄럽지 않을 것이다. 그러나 새로운 문화나 하위문화가 항상 주류 문화에 대해 껄끄러웠다는 점은 인정해야 한다. 이들이 메인스트림으로 변한다 해도 초기의 그 이상한 에너지와 열정은 신비로운 것이며 다른 혁명이나 문화 활동에서도 공통적으로 나타났던 일들이다.

역사적으로도 비슷한 예가 있다. 산업혁명이 초기에 당시로서는 지극히 이단적이던 유니태리언파 사람들이나 프리메이슨, 아니면 그에 못지않게 비표준적이던 사람들에 의해 시작되었다는 것을 역사책에서는 잘 다루지 않는다. 교육 배경이나 사회적 지위가 아니라 스스로의 생각에 따라 움직일 수밖에 없던 사람들은 언제나 많은 것이다. 이들을 산업기계문명의 해커라고 불러도 하나도 이상한 일이라고 할 수 없을 것이다.

컴퓨터 문화의 전부는 아니더라도 중요한 요소들이 컴퓨터에 빠져있던 사람들의 정서를 반영한다. 세속적인 일이 아니라 컴퓨터에 빠져있던 이상한 사람들의 이야기는 방송으로도 나왔다. 예전에 미국 PBS에서 크린즐리의 'Triumph of the Nerds'라는 프로그램을 방송한 적이 있다. 이 프로는 상당한 인기를 모았다. 주식 시장에서 IT 주식이 마구 오르던 시절이어서 이 프로그램은 사람들의 반발을 사지도 않았다. 기묘한 괴짜인 너드들이 영웅시되기 시작했다. 결국 한때 괴짜 같던 컴퓨터 문화가 중요한 무엇으로 인정받았음을 의미한다. 컴퓨터 문화라는 것은 이상한 일도 아니었으며 예전과 달리 중요하지 않다고 생각하는 사람도 별로 없다.

산업혁명의 발전이 만들어낸 변화들이 모두 밝은 측면만을 가지는 것은 아니며 러다이트 운동이나 다른 노동운동 문화를 만들어낸 것도 사실이다. 컴퓨터에 대해서도 사람들이 반드시 밝은 측면만을 바라보는 것은 아니다. 그러나 초창기에 결정적인 변화를 만들어낸 사람들은 그들만의 강렬한 에너지가 있었다. 산업혁명이나 르네상스와 같은 시절에도 분명히 어떤 사람들의 강렬한 지적인 에너지가 있었다.

물론 해커들만 이상한 것은 아니다. 그들 주위의 일상도 정상적인 것은 아니었다. 1세대 해커들이 활동한 1960년대와 1970년대의 사회 분위기를 정상으로 보기도 어렵다. 그때가 좋은 시절이었는가를 생각해 보면 당시 사회의 광기어린 면들을 지적하지 않을 수 없다. 2차 대전이 끝나고 미국과 소련이 주도하는 냉전이 최고조에 달했던 시절이다. 군부 출신 대통령 아이젠하워가 걱정스러워 할 정도로 비대해진 군산복합체가 있었고 언제라도 핵전쟁이 터질지 모른다는 불안한 생각이 사회를 지배하던 시절이었다. 그리고 방위에도 과학기술 발전이 필수적이라는 것을 알게 되면서 이들의 돈이 컴퓨터를 연구하는 분야에도 투자되었다. 소련이 인공위성을 먼저 발사하면서 갑자기 엄청난 돈이 과학 연구에 투자되었다. 당시 사회에도 약간 미쳐 보이는 요소가 없는 것은 아니었다.

고가의 장비이던 컴퓨터를 만지는 사람들도 이 자금으로부터 무관하지는 않았다. 양심을 지키기 위해 최선을 다했다 해도 그렇다. 컴퓨터를 하려면 주류 문화의 설비를 이용하지 않을 수 없었다. 당시 지배층의 아이디어와 사회 통제에 대한 집착이 실제로는 누구의 생각과 이해관계를 반영하는가에 대해 생각하지 않을 수 없다. 그리고 악의에 찬 지배와 관리에 대한 집착이 아니더라도 그 집착에 이르게 한 판단의 근거들이 옳았는지를 생각하지 않을 수 없다. "옳다와 그르다"의 경계점은 항상 애매하기 때문에 근거에 대해 생각해보지 않을 수 없는 것이다. 사회 규정이나 규범에도 언제나 버그가 꽤 많이 존재한다.

요즘 세계화와 지적 자본주의 속에서 우리의 활동에 대해 후세에 어떤 비평을 들을지는 미지수다. 자유롭게 보이는 우리의 IT 산업과 문화는 복잡한 관계의 거미줄 속에서 자유롭지 않다. 회사와 기업에서 발생하는 새로운 통제는 얼마든지 우리를 얽매고 있을 수 있다. 실제로 기업들은 생존을 위해 여러 가지 일을 해왔던 것도 사실이다. '옳다와 그르다' 또는 '정상적이거나 묘해 보이는' 일들도 항상 새롭게 생각해 보지 않을 수 없다.

비판의식을 갖건 비판의식을 갖지 않건 하위문화는 강렬한 관심과 집중으로 만들어지는 작은 종교집단처럼 보인다고 한다. 사람들이 빠져있는 관심의 원은 그 자체가 하나의 작은 세계로 다른 세계와 구별된다. 완전히 빠져든 사람이 있다면 그것이 세상의 중심이다. 그리고 이런 중심은 도처에 있다. 영원하지는 않더라도 하위문화의 에너지는 쉽게 사라지지 않는다. 또한 이 에너지가 없다면 변화는 일어나지 않는다. 에너지 변화를 수반하는 몰입은 드문 일이 아니다. 사람들은 한때 문학에 열중한 적도 있었으며, 음악에 열광하거나 정치나 전쟁에 열광한 적도 있었다. 팝 문화나 TV나 영화에 빠져든 적도 있으며 모든 문화 영역은 이런 에너지로 넘친다. 글을 쓰다 보니 다른 문화와의 유사점만을 부각했지만 그것은 사실이다. 언제나 일어나는 현상인 것이다!

그 중에서 필자는 컴퓨터의 문화 원동력이었던 해커에 대해 이야기하고 있는 것이다. 우리가 과거의 해커들에 대해 어떤 식으로 규정하느냐는 바로 같은 업종에서 일하거나 관심을 갖는 우리의 일에 대한 새로운 해석을 필요로 한다(독자들은 이와 비슷한 말을 다른 역사책에서 이미 많이 들었을 것이다).

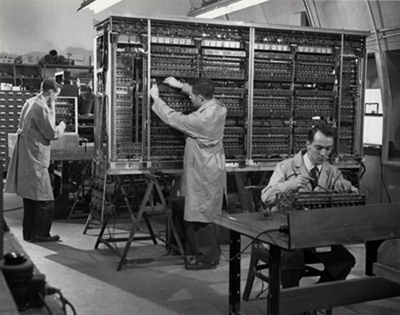

하드웨어와 교감하다

초창기 컴퓨터는 많은 개량이 필요한 것이었다. 제작회사들이 아무리 멋있게 포장을 해도 당시 기계들은 요즘의 작은 IC 하나만도 못한 능력을 가졌다. 1초에 10만 번 덧셈을 할 수 있는 정도였다. 컴퓨터 하드웨어는 별것이 없었다.

하드웨어의 예를 들기 위해 오디오 앰프의 예를 들어보자. 오래전에 오디오라는 것은 별것이 없었다. 진공관 몇 개로 만든 앰프를 가지고 오디오광들은 신비스러운 음악의 세계로 빠져들었다. 당시의 명기라는 설계들도 회로로 보자면 오늘날의 기준에서 초라하기 그지없다. 주요 음원인 LP 판에서 나올 수 있는 소리의 질도 제한적인 것이었다. 그러나 많은 사람들은 빈약한 하드웨어의 경계를 넘어 소리에 빠져들었다. LP 판에서 나오는 잡음도 큰 방해가 되지는 못했다. 판을 너무 열심히 듣다 보면 골이 닳아버려 LP 판의 물리적인 수명이 다하곤 했다.

>

>

그림 1. 하나의 진공관으로 만들어진 앰프. 사실상 트랜지스터 1개에 해당한다.

그러나 적어도 최소한도의 구현은 있어야 했다. 매우 초기에는 오디오를 듣는 사람과 만들고 개선하는 사람을 구분하기 힘들었다. 초기 오디오 설계와 구현은 많은 에너지의 집중을 필요로 했다. 하지만 최소한도의 세팅이 이루어지고 사람들이 이것을 좋아하기만 한다면 그 관심과 집중은 많은 변화를 만들어낼 수 있었다. 사람들은 수백 개의 음반을 듣고 수집하기도 하며 음반을 평가하고 관리하는 일도 큰 사업이라는 사실을 알게 된다. 레코드 시장도 커져갔다.

컴퓨터 역시 마찬가지였다. 일단 최소한도의 것들이 만들어지자 컴퓨터에 빠져드는 사람들이 늘기 시작했다. 당시 자료들을 검토하고 있자면 놀랄만한 일들이 한두 가지가 아니다. 1950년대는 말할 것도 없고 1960년대에 들어와 트랜지스터를 이용한 컴퓨터가 나오기 시작했을 때의 하드웨어도 빈약하기는 마찬가지였다. 예를 들면 플립플롭 회로 하나가 작은 책자 정도 크기였는데 레지스터의 1비트에 해당했다. 그러니까 책꽂이 하나가 1워드가 되는 셈이다. 커다란 컨트롤 패널이 보여주는 정보는 요즘의 디버거 한 줄의 정보에도 미치지 못할 때가 많았다. 프로세서 유닛의 명령은 다이오드와 배선으로 하드와이어 연결이 이루어져 있었다. 이 정도의 기계도 줄을 서야 사용할 수 있었다. 레지스터와 컨트롤 유닛, ALU 같은 것은 구조가 밖에서도 훤히 보였다.

>

>

그림 2. 초창기 PDP-1의 모듈의 일부. 이 모듈은 NOT의 기능을 수행하고 이런 모듈들을 모아 PDP-1이 만들어졌다.

>

>

그림 3. 몇 년이 지나자 TTL IC 한 개가 모듈의 기능을 대체할 수 있게 되었다.

교감하고 집중하는 것이 사실상 프로젝트의 성공과 실패를 좌우하는 일이다. 많은 프로젝트들은 사람들의 관심과 집중을 받지 못해 실패했다. 반대로 아주 빈약한 하드웨어라도 사람들의 힘과 정신력의 집중은 대단한 결과를 만들어낸다. 개발 프로젝트의 대상은 사람들과 교감한다. 개인적인 생각이지만 필자는 사람들의 머릿속 코딩이 기계의 코딩에 우선한다고 생각한다. 초창기에는 더 중요하다. 몇 년을 우회할 발전이 며칠 만에 해결되는 수도 있다. 그래서 우선은 사람들을 코딩되어야 한다.

어떤 일을 너무 좋아하는 사람들이 나타나면 일은 빠르게 진행된다. 컴퓨터가 이들에게는 세상의 중심이었다. 오늘날의 컴퓨터에 비하면 빈약한 하드웨어와 소프트웨어였으나 이것으로도 교감할 수 있었다. 하드웨어는 언제나 더 많은 개선을 필요로 했고 최고의 효율을 발휘해도 언제나 연산능력과 메모리는 부족했다.

초창기 컴퓨터라는 것은 비싼 장비였기 때문에 사용에 제약이 가해지기는 했으나 컴퓨터 제작회사의 엔지니어나 그것을 사용하는 해커들은 실험적으로 많은 해킹을 했다. 기술적으로 특별히 감출만한 것들도 없었다. 나중에 그 기계 사용자들이 회사에 입사해 새로운 컴퓨터들을 만들어 내기도 했다. 필자는 과연 당시 사용자들이 새로운 시도를 중지하고 제작회사에서 하라고 정한 일들만 하는 것이 옳았는지 아니면 왕성한 실험정신을 발휘한 것이 맞았는지에 대해 생각해 보아야 한다고 믿는다(물론 필자의 생각은 이단적일 수 있으며 생각하기에 따라 맞을 수도 틀릴 수도 있다).

이 정도의 하드웨어에서 지난번에 설명한 것과 같은 리스프 인터프리터가 구현되었다. 초기에는 리스프에 제한이 너무 많았다. 리스프가 상당히 개선된 것은 코톡이라는 해커가 설계한 컴퓨터에 그린블러트의 MacLISP가 구현되고부터다. 코톡은 나중에 DEC로 가서 PDP-6의 주 설계자가 되고 PDP-6은 나중에 PDP-10이 된다.

1970년대에 이미 36비트 컴퓨터가 존재했다. 다시 몇 년의 세월이 지나자 초기 해커들은 몇 명을 제외하고는 대부분 자리를 옮겼다. 컴퓨터가 세상의 중심이었던 사람들 역시 체력과 집중력이 약화되는 것을 몸으로 느꼈을 뿐만 아니라 사회적, 경제적인 제약으로부터 자유롭지 못했다. 초기 리스프 해커들의 전성기는 10년 정도 지속되었다.

>

>

그림 4. PDP-1(www.computerhistory.org 의 사진에서)

람다 계산법(Lambda Calculus)

열정과 집중이 중요하다는 이야기를 너무 길게 한 것 같다. 이제 다시 리스프 이야기로 돌아오자.

리스프가 람다 표기법을 채택한 것은 지난번에 설명했다. 리스프 프로그램에 대해 자세히 설명하지도 않고 리스프 인터프리터를 만드는 이야기를 진행하였으니 황당하기는 하지만 실제로 리스프는 그렇게 갑자기 세상에 나타난 것이다.

리스프는 함수를 람다 표기법으로 나타낸다. 람다 표기법은 특별히 수나 기호를 구분하지 않는다. 람다 표기법은 조금 생소한 것이라 설명이 필요하다. 람다 계산법은 치환을 다루는 계산법이다. 전반적인 내용이나 배경이 위키백과에 상당히 잘 정리되어 있다. 필자는 람다 계산법을 설명하기 위해 'An Introduction to Lambda Calculus and Scheme'에 나오는 예제를 그대로 몇 개 인용해 보았다.

함수는 입력을 받는 부분과 결과를 내는 부분이 있다. 이제 우리가 어떤 대상에 초콜릿을 씌우는 함수를 갖고 있다고 생각하고 다음과 같은 것을 생각해 보자.

peanuts -> chocolate-covered peanuts

raisins -> chocolate-covered raisins

ants -> chocolate-covered ants이것을 람다 계산법을 사용하여 표현하면 다음과 같다.

Lx.chocolate-covered x여기서 L 은 람다(λ)를 나타낸다. 함수에 인자를 대입하는 것을 다음과 같이 표시한다.

(Lx.chocolate-covered x)peanuts -> chocolate-covered peanuts람다 계산법에 따르면 람다식에 어떤 인자를 적용한 결과가 또 하나의 함수일 수도 있다. 초콜릿이 아니라 캐러멜을 포장할 수도 있는 것이다. 이를테면 아래와 같은 람다식을 만들 수 있다. 이 식은 y 로 싸인 x 를 만드는 것이다.

Ly.Lx.y-covered x이제 캐러멜을 덮는 함수를 만들어낼 수 있다. 식은 y 인자로 캐러멜을 받았다.

(Ly.Lx.y-covered x)caramel -> Lx.caramel-covered x그리고 이 함수는 다시 땅콩을 덮도록 만들 수 있다. x 인자로 peanuts 를 받았다.

(Lx.caramel-covered x)peanuts -> caramel-covered peanuts함수의 인자가 반드시 숫자일 필요는 없다. 람다 계산법에서 함수는 다른 함수의 인자가 될 수도 있다. 지난번의 간단한 인터프리터에서도 함수를 다른 함수의 입력으로 사용할 수 있었다. 아래 식에서 f 인자는 함수다.

Lf.(f)ants그래서 초콜릿을 포장하는 함수를 ant 에 적용할 수 있다. (apply-to-ants) 를 잘 살펴보면 단순한 치환이 이루어지는 것을 알 수 있다. () 의 주변을 잘 살펴보라. f 는 Lx.chocolate-covered x 로 대체되었다. 그리고 x 에는 ants 가 적용되었다.

(Lf.(f)ants)Lx.chocolate-covered x

-> (Lx.chocolate-covered x)ants

-> chocolate-covered ants함수가 한 람다식을 적용한 결과로 만들어질 수 있다는 것은 대단한 일로 많은 가능성을 갖고 있다. 이런 것을 클로저(closure)라고 부르기도 하며 리스프나 스킴(scheme)에서 고차함수를 만드는 바탕이 되었다.

자세한 증명은 람다식을 다루는 문헌들을 찾아보기로 하고 람다 계산법이 왜 일반적인 컴퓨팅의 원리로 변할 수 있었는지를 생각해 보자. 사실 컴퓨터는 구현 이전부터 만들어질 수 있는 방법이 있었다. 그 중 하나는 람다 계산법을 통해서다. 전기 스위치를 사용하건 다른 기계적인 무엇을 사용하건 만들어질 수 있었다. 구현 논리는 이미 수학적으로 존재했다. 우선 조건식을 람다함수로 만들어낼 수 있다. 이를테면 참과 거짓을 다음과 같이 만들어낼 수 있다.

true = Lx.Ly.x

false = Lx.Ly.y

if-then-else = La.Lb.Lc.((a)b)c매우 생소하기는 하지만 논리식을 람다 함수로 표시해본 것이다. 몇 개의 치환을 거쳐 람다 함수는 조건식을 정확히 계산한다. 아래의 식은 if-then-else 가 참이면 apple 을, 거짓이면 banana 를 돌려주도록 되어 있다. 미리 false 를 적용한 것이라 banana 를 돌려준다.

(((if-then-else)false)apple)banana

-> (((La.Lb.Lc.((a)b)c)Lx.Ly.y)apple)banana

-> ((Lb.Lc.((Lx.Ly.y)b)c)apple)banana

-> (Lc.((Lx.Ly.y)apple)c)banana

-> ((Lx.Ly.y)apple)banana

-> (Ly.y)banana

-> banana간단한 정리 몇 개를 적용한 것치고는 많은 일을 할 수 있는 것 같다는 생각이 들지 않는가? 아무튼 앞서의 초콜릿과 캐러멜을 치환하는 식과 peanuts, raisins, ants 를 치환하는 방법을 그대로 적용한 것이다. 종이와 연필로 계산해볼 수 있다. 지난번의 cons 와 car, cdr 도 람다식으로 표현할 수 있다.

cons = La.Lb.Lc.((c)a)b

car = Lx.(x)true

cdr = Lx.(x)false이런 방법으로 생각하는 cons, car, cdr 의 정의가 나름대로 중요한 내용이라 실제로 SICP의 비디오 강의 5b에서는 중요한 개념으로 떠오른다. 강의에 나오는 스킴 식에서는 다음과 같이 정의했다.

(define (cons x y) (lambda(m) (m x y)))

(define (car x) (x (lambda (a d ) a))

(define (cdr x) (x (lambda (a d ) d))이 식을 실제로 수행하면 다음과 같다.

(car (cons 35 47))

-> (car (lambda (m)(m 35 47)))

-> ((lambda(m)(m 35 47)) (lambda(a d) a))

-> ((lambda (a d) a) 35 47)

-> 35별것 아닌 것처럼 보이는 내용이겠지만 위 정의를 조금 더 변형하면 사이드 이펙트(side-effect)를 만들어낼 수도 있고 함수형 언어에서 덮어쓰기(assignment)의 메커니즘을 만들어낼 수도 있다. 재귀(recursion) 역시 람다식을 이용해 만들어낼 수 있다. Y 컴비네이터라고 부르는 것인데 리스프에서는 label을 이용한 다른 방법으로 구현했다.

리스프라는 언어는 이런 람다 계산법을 적용하는 하나의 이론적인 기계 그 자체이며(지난번에 설명한 간단한 evaluator 그 자체가 A4 용지 한 페이지 정도의 식이다) 리스트로 되어있는 다른 리스프 식을 읽어 이들을 치환하여 계산을 하고 경우에 따라 수식이나 새로운 함수 자체를 답으로 되돌린다.

Paradigms of Artificial Intelligence Programming

초창기 해커들이 관여하던 몇 가지 문제들을 정리한 책이 있다. 리스프가 개발되고 문제의 표현을 위해 사용되던 곳이 인공지능(AI) 분야였기 때문에 당연히 리스프에는 좋은 예제가 많았다.

피터 노빅(Perer Norvig, http://norvig.com )이 쓴 책 중에 『Paradigms of Artificial Intelligence Programming: Case Studies in Common Lisp』라는 유명한 책이 있다. 첫 회에 소개한 SICP보다 더 어려운 수준의 책(하드코어에 속한다고 하는 사람도 있다)이지만 리스프로 어떻게 인공지능 문제들을 접근했는지에 대한 좋은 자료다. 책의 2부는 초기 AI 프로그램을 다루고 분석하고 있다. 이를테면 GPS(General Problem Solver), ELIZA, 수학적 기호처리 같은 것들을 다룬다.

피터 노빅(Perer Norvig, http://norvig.com )이 쓴 책 중에 『Paradigms of Artificial Intelligence Programming: Case Studies in Common Lisp』라는 유명한 책이 있다. 첫 회에 소개한 SICP보다 더 어려운 수준의 책(하드코어에 속한다고 하는 사람도 있다)이지만 리스프로 어떻게 인공지능 문제들을 접근했는지에 대한 좋은 자료다. 책의 2부는 초기 AI 프로그램을 다루고 분석하고 있다. 이를테면 GPS(General Problem Solver), ELIZA, 수학적 기호처리 같은 것들을 다룬다.

책을 사볼 필요는 없겠지만 Paradigms of Artificial Intelligence Programming에서 'Excerpts from the preface, including why Lisp?' 같은 글들을 읽어 보기 바란다. 어려운 내용도 아니며 좋은 생각거리를 제공할 것이다. 그 외에도 좋은 글들이 꽤 많다.

Part4: 액터와 람다

2007년 7월 18일

들어가며

지난번에는 람다에 대해 간단히 적었다. 람다 계산법이 이상하게 보인다 해도 너무 심각하게 생각하지 않아도 된다. 당장은 이해할 필요도 없다. 이해에는 많은 시간이 걸릴지도 모르며 이해하지 않아도 별 문제는 없을지도 모른다. 컴퓨터를 잘 몰라도 IT 개발 업무에 종사하는 사람이 상당수 있는 것처럼 람다를 잘 모른다고 큰 문제가 생기는 것도 아니다. 실제 코드를 짜는 일에 람다 계산법을 적용하는 일도 별로 없다. 리스프는 이미 람다를 충실하게 구현하고 있다.

필자의 임무는 리스프 여행 가이드이므로 너무 어렵지 않게 이야기를 적어 나가야 한다는 것을 안다. 읽다가 호기심이 생기는 부분이 있으면 찾아볼 자료들은 얼마든지 있을 것이다. 이번 이야기는 람다가 중요한 화두로 등장하는 역사적 사실의 배경이다. 그 시작은 서스만과 스틸의 스킴(Scheme)이 람다 페이퍼들과 함께 나왔고 람다 페이퍼가 나온 이유는 이들이 액터 모델(actor model)을 이해하고 싶어 했기 때문이다.

액터 모델은 칼 휴이트(Carl Hewitt)라는 총명한 학자가 제시한 모델이다. 사실 이번 이야기는 액터 모델보다도 휴이트가 주인공이다.

휴이트와 액터

어느날 칼 휴이트가 람다와는 관련이 없어 보이는 액터 모델이라는 이론을 들고 나왔다(Carl Hewitt, Peter Bishop, Richard Steiger(1973). 「A Universal Modular Actor Formalism for Artificial Intelligence」). 람다가 하나의 계산 형태인 것처럼 액터 역시 형식이 중요하다. 이 모델에서 세상의 모든 것은 액터라는 개념을 채택했다. 마치 객체지향 프로그래밍에서 모든 것이 객체이며 리스프에서는 모든 것이 리스트인 것과 같다.

액터는 객체보다 더 동시적인 모델이다. 액터는 물리적인 세상을 추상화하려는 시도에서 나왔다(반면 람다는 논리적인 모형으로부터 나왔다). 물리적인 시스템에서 중력이나 전기장은 다른 요소들과 직접적, 동시적으로 영향을 받는다. 액터는 이러한 동시적 작용을 위한 메시지를 보내는 모델을 만들고자 했다(액터와 비슷한 것들은 여러 번 등장했다. 우선 정보이론 자체가 맥스웰의 도깨비에 대한 새넌과 위너의 고민으로부터 나온 것을 생각해 보면 된다. 더 거슬러 올라가면 라이프니츠의 모나드(monad) 이론부터 시작한다). 액터는 컴퓨터상의 존재로 메시지를 받으면 다음과 같은 일을 동시적으로 만들어낼 수 있다.

- 다른 액터에 한정된 개수의 메시지를 보낼 수 있다.

- 유한한 개수의 액터를 만들어낼 수 있다.

- 다른 액터가 받을 메시지에 수반될 행동(behavior)을 지정할 수 있다.

- 이런 일들이 동시적으로 진행되는 데 있어 미리 정해진 순서는 없다.

통신은 비동기적이며 메시지를 보내는 액터는 메시지가 다 수신되기를 기다리지 않는다. 메시지 수신자는 주소로 확인되며 우편주소라고 부른다. 그래서 액터는 주소를 갖고 있는 액터들에 한해 통신할 수 있다. 주소는 수신하면서 알아낼 수도 있고 자신이 만든 액터의 주소일 수도 있다. 요약하면 액터 모델은 액터들 사이의 동시적 계산, 액터의 동적인 생성, 메시지에 액터의 주소를 포함시킬 수 있는 것, 그리고 도착순서의 제한을 받지 않은 비동기적 메시지 전달을 통한 상호작용이 특징이다.

내용을 읽다 보면 액터 모델과 비슷한 것이 우리가 사용하는 전자우편이라는 생각이 들지 않는가? 실제로 그렇다. 액터 모델의 내용을 읽고 있으면 리턴 값을 전달하는 이야기가 없으며 실제로 계산 값은 메시지를 전달하면서 전해질 수 있다. 그래서 액터 방식으로 계산하는 방법은 함수나 서브루틴을 호출하여 2와 3을 더하여 5를 리턴 받는 것이 아니다. 이를테면 다른 액터에 3이라는 값을 보내면서 여기에 2를 더할 것을 요구하는 메시지와 함께 전송하는 것이다. 이상하게 보이는가?

이상하게 생각할 것은 없다. 이메일로 지시를 보내 일을 처리하는 방식을 확장하면 된다. 메시지를 여러 번 보내고 받으면 복잡한 일도 처리할 수 있다(어떤 사람들은 웹 서비스의 SOAP 모델도 액터 모델로 잘 표현할 수 있다고 생각한다).

휴이트의 액터는 람다 계산, 스몰토크(Smalltalk), 시뮬라의 영향을 받았다. 이들은 동시에 휴이트의 영향을 받았다.

우선 람다 계산부터 살펴보자. 위키백과 영어판의 액터 모델에서 람다 계산법을 이용한 메시지 전달은 다음과 같다.

λ(leftSubTree,rightSubTree)

λ(message)

if (message == "getLeft") then leftSubTree

else if (message == "getRight") then rightSubTree얼핏 보면 단순한 치환(substitution)이다. 그러나 서스만과 스틸은 스킴을 만들면서 환경(environment)이라는 개념을 도입하면서 리스프를 다시 해석하게 되었다(액터를 이해하기 위해 서스만과 스틸이 만든 장난감 리스프 언어가 스킴이 되었다. 휴이트와 이야기를 나누던 서스만은 사소한 점 두 가지를 제외하고는 람다와 액터 모델이 거의 일치한다는 것을 알았다). 스틸은 이 내용을 「The History of Scheme」이라는 글에서 요약했다. 람다가 개별적으로 상태 변수를 갖고 서로 값을 주고받으면서 액터의 역할과 같은 일을 할 수 있다는 것을 알았다. 동시성 문제가 완전히 해결된 것은 아니지만 리스프 구조에 큰 변화가 왔고 그 와중에 지난번에 소개한 'the original lambda papers'라는 것들이 나왔다. 람다라는 것은 개념으로부터 하나의 완벽한 계산상의 실체가 되었다.

별다른 내용이 아닌 것 같지만 프로시저나 함수들, 액터, 객체 그리고 람다 객체들이 메시지를 주고받는 패턴으로 컴퓨터의 제어 구조를 결정한다는 간단하면서도 심오한 결론에 도달한다. 운영체제의 IPC가 얼마나 복잡해질 수 있는가를 이해할 수 있는 독자라면 같은 패턴이 언어에도 적용된다는 것을 알 수 있다. 객체가 사용하는 메시지 전달 같은 것은 그 다양한 종류의 하나일 뿐이다.

사실 조금만 파고들어도 복잡한 측면들이 나타난다. 일부 객체지향 언어에서 메시지는 객체를 통제하는 거의 유일한 수단이다. 만약 객체가 메시지에 반응한다면 그 객체는 메시지에 대한 메서드(method)를 갖고 있는 것이다. 객체지향 언어보다 먼저 나타난 구조적 프로그래밍에서 메시지를 보내는 방법은 함수 호출이다. 그 이전에는 포트란이나 베이직처럼 직접 goto(jump)하는 방법이 있었다. 프로그램이 제어를 전달하는 방법에서 jump는 나쁜 방법이 아니다. 많은 문헌에서 컨티뉴에이션(continuation)이라고 부르는 방법도 제어와 메시지를 전하는 방법이다. 스택을 쓰지 않아도 컨티뉴에이션으로 해결할 수 있고 파이썬이나 그 외 몇 가지 언어에서는 이미 시험대에 오른 문제이기도 하다. 차이가 있다면 일의 종류나 알고리즘에 따라 얼마만큼 우아하고 추상적으로 표현할 수 있느냐가 관건이다.

리스프에서 스킴을 만든 팀만 휴이트를 만난 것이 아니다. OOP 발전에 결정적 영향을 미친 알런 케이(Alan Kay)도 휴이트를 만났다. 먼저 알란 케이가 스몰토크를 만들면서 메시지 패싱의 사고방식에 영향을 받았다. 메시지 패싱은 최초의 객체지향 언어라고 하는 시뮬라에 처음 모습을 나타냈다. 휴이트의 경우 메시지 패싱은 패턴 지향적으로 플래너(Planner)를 불러내는 데 사용되었다. 플래너는 휴이트가 만든 인공지능 언어이며 여기서 메시지 패싱의 개념을 설명하고 있다. 이것이 스몰토그-71 개발에 영향을 주었다. 얼마 후 휴이트 역시 스몰토크-71에 의해 크게 자극 받았으나 구현 방법이 너무 복잡한 것이 문제였다.

1972년 케이는 스몰토크-72에 대한 아이디어와 세이모어 패퍼트(Seymour Papert)의 로고(Logo)에 나오는 'little person'의 개념을 토론하기 위해 MIT를 방문했다. 그러나 스몰토크-72의 메시지 패싱은 정말 복잡했다. 그래서 나중에는 메시지 패싱에 근거하는 동시 계산의 수학적 모델은 적어도 스몰토크-72보다는 간단해야 한다고도 했다. 스몰토크의 나중 버전들은 시뮬라의 모델을 따랐다. 휴이트의 메시지 패싱에 대한 방법론이 케이에게 영향을 준 것은 분명하지만 액터 모델도 케이의 영향을 받았다.

스몰토크가 GUI와 데스크톱 그래픽 환경에 결정적 영향을 준 것에 비해(PARC의 워크스테이션과 매킨토시 그리고 스퀵) 액터는 컴퓨터 이론과 공학에서 다루어졌다. 역사의 개괄은 간단하지만 둘은 서로 많은 영향을 주고받았다(우리가 알고 있는 객체의 개념이 세포의 영향을 받은 것이라든지, 북유럽에서 날아온 알골의 변형인 시뮬라의 영향 같은 것은 모두 튜링상을 받은 사람들의 가장 중요한 개념이었음에도 불구하고 별로 알려져 있지 않다. 신기하게도 세부적인 언어 구현의 요소들에 대해 고민하면서도 문제 자체를 문제로 고민할 기회는 상대적으로 적었다).

언어는 어느 정도까지 추상화나 세계의 모습을 제공해야 하는가? 그것은 잘 모른다. 하지만 언어에서 생물학적 모델, 물리학적 모델 같은 것을 다룰 때 메시지 패싱은 중요한 부분이다(물론 독자들은 메시지 패싱이 본질적이며 골치 아픈 내용이라는 것을 잘 알고 있을 것이다). 이 문제는 아무튼 30년이 넘게 중요한 화두로 작용했다.

휴이트가 던진 화두에 리스프 해커들은 람다를 골똘히 연구하는 것으로 문제를 해결했다. 람다 함수의 인스턴스는 제한이 없으며 서로 전부 다른 상태(state)를 만들 수 있기 때문에 수많은 객체가 있는 것과 마찬가지다. 여기서 람다들이 어떤 측면(aspect)을 바라보도록 설계하는지가 중요한 문제다.

SICP 3장은 이런 모델링의 중요한 모습을 드러낸다. 리스트를 기계의 부속을 연결하는 것처럼 사용하는 코드들이 나온다. 5장에 가면 재귀(recursion)와 컨티뉴에이션이 실제 언어 구현에서 어떻게 제어를 넘기는지 극명한 예들을 제시한다. 이런 것들을 학부 학생들에게 가르치겠다는 과감한 시도가 SICP에 사람들이 열광하는 이유다. 물론 싫어하는 이유이기도 하다.

SICP 3장은 이런 모델링의 중요한 모습을 드러낸다. 리스트를 기계의 부속을 연결하는 것처럼 사용하는 코드들이 나온다. 5장에 가면 재귀(recursion)와 컨티뉴에이션이 실제 언어 구현에서 어떻게 제어를 넘기는지 극명한 예들을 제시한다. 이런 것들을 학부 학생들에게 가르치겠다는 과감한 시도가 SICP에 사람들이 열광하는 이유다. 물론 싫어하는 이유이기도 하다.

책을 보며 필자가 느낀 기묘한 느낌은 오랫동안 머릿속에 남아있었다. 그런데 필자만 그런 것을 느낀 것은 아니었다. 필자는 예전에 김창준 님이 워드 커닝엄(Ward Cunningham)과 인터뷰한 글을 떠올렸다(워드 커닝엄과 켄트 벡은 패턴을 컴퓨터 프로그램에 적용하는 실험적 작업을 20년 전에 시도했다). 그 내용이 박스 기사에 소개되어 있다.

액터 모델은 오랫동안 많은 사람들에게 영감을 준 화두다. "핵심적 내용인 메시지 패싱에 대해 생각해 보면 좋을 것이다" 정도가 필자의 간단한 결론이 되겠다. 어떤 형식으로 요소들 간에 메시지를 주고받게 할 것이며 어떤 기구를 제공할 수 있는가 하는 문제는 답이 나지 않는 문제다. 그래서 계속 생각해 볼 화두로서 가치는 충분하다.

조금만 생각해 보는 것으로도 우리가 아는 언어에 대한 상식들에 대한 새로운 관점들을 얻을 것이다. 그리고 이 주제들은 SICP 5장에서 반복적으로 나온다.

>

>

그림 1. Viewing Control Structures as Patterns of Passing Messages

그림은 휴이트의 「Viewing Control Structures as Patterns of Passing Messages」에 나오는 그림이다. 재귀를 이용하여 팩토리얼을 계산하는 문제를 메시지 패싱으로 본 그림이다. 생각하기에 따라 메일로 메시지를 보내는 것처럼 문제를 해결할 수도 있다. 수신자 숫자를 늘리거나 더 복잡한 동작을 시킬 수도 있다. 이 그림은 「History of Scheme」에서 다른 방법으로 설명한다.

휴이트의 다른 작업 플래너

공교롭게도 칼 휴이트, 제럴드 제이 서스만, Terry Winograd는 모두 세이모어 패퍼트의 제자였다. 플래너는 휴이트가 만든 언어의 이름이다. 지식(knowledge)을 정의하면서 지식을 논리 수학의 형식으로 정리해야 한다는 매카시 같은 사람들의 생각과, 고수준의 프로시저 플랜의 형태로 지식을 표현할 수 있다는 사람들의 의견이 있었다. 플래너는 두 방법을 혼합한 형태였다. 인공지능 언어는 리스프 뿐만 아니라 여러 가지가 있었고 플래너는 그 중 하나였다. 플래너는 너무 방대하기 때문에 피코플래너나 마이크로플래너 같은 부분적 구현들도 있었다.

- 리스프(매카시 외, 1958)

- 플래너(휴이트, 1969)

- 마이크로플래너(서스만 외, 1971)

- Conniver(서스만 외, 1972)

- 플라즈마(휴이트 외, 1973)

- Schemer(서스만과 스틸, 1975)

이들은 1970년대 초반 마이크로플래너를 홍보하기 위해 에딘버그를 방문한다. 서스만과 Terry Winograd는 에딘버그 대학을 방문하여 새로운 버전인 마이크로플래너의 소식을 전하고 증명 방법의 절차 논리를 논의했다. 에딘버그에는 피코플래너라는 마이크로플래너의 축소판과 완전한 플래너가 구현되어 있었다. 에딘버그의 논리학자 코왈스키와 헤이스는 마이크로플래너의 많은 부분이 전통적인 수학적 논리에 의해 수행될 수 있다는 것을 알았다. 그래서 코왈스키는 마이크로플래너의 일부를 사용하여 프롤로그(Prolog: programming in logic)의 아이디어를 떠올리고 마르세이유 대학에서 프롤로그가 구현되었다. 그래서 프롤로그가 나오는데 이것은 미국의 연구팀에게는 충격이었다.

유럽 연구자들은 리스프를 잘 몰랐으나 플래너의 개념은 알고 있었고 미국 학자들은 우아하게 자신의 연구를 포장하지 못했다. 플래너의 개념이 명제 논리학과 만나자 프롤로그가 나왔다. Colomeur와 다른 연구자들에 의해 새로운 언어와 형식이 나온 것이다. 프롤로그는 플래너보다 많이 간단했고 큰 장점으로 작용했다. 간단히 배워 논리 프로그래밍을 배울 수 있었다. 프롤로그는 유럽에서 많이 사용되었다.

결국 기본적 도구를 만들어 준 셈인데 프롤로그는 또 다른 하나의 강력한 주류로 나타난다. 플래너에서 지식에 대해 '절차적 지식의 구현'의 개념이 조금 명확해졌다면 다른 형식을 빌려 선언형 지식(declarative knowledge)의 모습을 떠올릴 수 있었다.

그 이후 리스프의 고급 교과서에는 프롤로그를 만드는 예제가 나온다, SICP와 지난번에 소개한 PAIP(Paradigms of Artificial Intelligence Programming)에도 프롤로그 인터프리터를 만드는 예제가 많은 지면을 할애하여 나온다. SICP의 논리 프로그래밍 장에는 몇 가지 간단한 법칙과 프레임으로 프롤로그 인터프리터를 만드는 방법을 설명한다. 그러면서 "훌륭하기는 했으나 이해하기는 어려웠던 휴이트의 박사 논문을 가지고 씨름하던 MIT의 연구자들에 의해 논리 프로그래밍을 연구 중이었으나" 하는 문장으로 시작하는 주석문이 있다. 지식을 표현하는 더 우아한 표현법이 있다는 것을 인정해야 했다.

지면상 더 쓸 수는 없지만 어떤 지식들은 '선언(declare)'될 수 있었던 것이다. 논리적으로 선언된 지식들은 법칙에 의해 프로그램을 자동으로 '생성'할 수 있다. 이상해 보이기는 하지만 사실이다. PAIP는 프롤로그에 너무 많은 지면을 할애한다고 비난까지 받았지만 정말 중요한 부분이었다.

스킴 칩과 리스프 머신

SICP 5장은 컴파일러, 그리고 조금 비약하면 스킴 칩까지 구현하는 내용이다. 이 칩의 가장 충격적인 특징은 소프트웨어가 자신이 실행될 하드웨어를 디자인하는 것이었다. 설계의 원형은 「Design of LISP-based Processors, or SCHEME: A Dielectric LISP, or Finite Memories Considered Harmful, or LAMBDA: The Ultimate Opcode」(Guy Lewis Steele, Gerald Jay Sussman, AI Lab memo, AIM-514)에 나온다. 이 글을 쓸 때는 1979년이었다. 당시로서는 획기적인 개념이었다. 설계의 많은 부분은 반도체 팀이 아닌 소프트웨어 디자이너들이 쓴 것이고 이 글은 유명한 카버 미드(Carver Mead)의 책이 나오기 전의 초고를 빌려 읽으면서 썼다. 책의 내용은 거의 30년이 되어가는 지금 보아도 흥미진진하다. 람다의 원형이 점차 간단해져 칩으로 변한다. 한편 출판된 미드의 책은 이 글을 중요한 사례로 인용했다.

SICP 5장은 개념적인 레지스터 머신(register machine)을 만들면서 설명하고 컴파일러를 만든다. 컴파일러는 점차 기계로 스킴을 옮긴다. 리스프 컴파일러의 서브셋과 기계의 요소는 크게 다르지 않다. 이런 일이 아주 쉬운 내용은 아니지만 아주 어려운 내용도 아니다. 그러나 정말 생각할 것이 많은 내용이다.

리스프는 함수를 람다 표기법으로 나타낸다. 람다 표기법은 특별히 수나 기호를 구분하지 않는다. 람다 표기법은 조금 생소한 것이라 설명이 필요하다. 람다 계산법은 치환을 다루는 계산법이다. 전반적인 내용이나 배경이 위키백과에 상당히 잘 정리되어 있다. 필자는 람다 계산법을 설명하기 위해 'An Introduction to Lambda Calculus and Scheme'에 나오는 예제를 그대로 몇 개 인용해 보았다.

5장의 주요 내용으로 나오는 컴파일러인 래빗(Rabbit)이라는 최초의 스킴 컴파일러가 가이 스틸의 석사 학위 논문이었다. 커먼 리스프와 스킴을 만드는 데 핵심적인 역할을 한 스틸은 졸업 후 다니엘 힐리스의 Thinking Machine에 합류한다. 수많은 프로세서, 적어도 몇 만개를 묶어놓은 프로세서들의 알고리즘은 사실상 스킴 칩 설계의 영향을 받았다. 스틸과 힐리스는 모두 서스만이 지도한 학생이었다.

>

>

그림 2. 스킴 칩의 내부회로

박스 기사 다음에 인용한 글은 워드 커닝엄과 김창준의 인터뷰의 일부로 월간 마이크로소프트웨어에 실렸던 글이다. 오늘 소개한 내용과 연관이 있다.

창준: 당신의 경력에 가장 많은 영향을 준 책이나 논문 혹은 사람이 있다면요? 워드: 카버 미드(Carver Mead)와 린 콘웨이(Lynn Conway)의 『VLSI 설계(VLSI Design)』에서 아주 많은 영향을 받았습니다. 대학에서 전기 공학을 공부할 때는 하나의 집적 회로 위에 앤드(AND) 게이트 하나를 어떻게 만들 수 있는지 배웠습니다. 미드와 콘웨이의 책에서는 컴퓨터 프로세서 전체를 어떻게 만들 수 있는지 배웠지요. 카버 미드는 제 영웅입니다.

창준: 『VLSI 시스템 입문(Introduction to VLSI systems)』을 말하는 것이죠? 프로그래밍 책 중에서 가장 영향을 많이 받은 책을 고른다면요? 워드: 네. 사실 그 책은 시스템 설계자를 위해 쓰였지 전기 기술자를 위해 쓰인 것이 아니기 때문에 그 책을 컴퓨터 프로그래밍 서적으로 생각합니다. 아델 골드버그(Adele Goldberg)와 데이비드 롭슨(David Robson)의 『Smalltalk: The language and its implementation』 책의 초고에서 객체를 배웠습니다. 제가 스몰토크를 '딱'하고 깨친 것은 스몰토크를 리스프(Lisp)로 구현해 놓은 장을 읽었을 때였습니다. 애석하게도 이 장은 책이 출판될 때 빠져 버렸습니다 *. 그 장을 읽기 바로 전 주에 제럴드 서스만과 가이 스틸의 '인터프리터의 기술(Guy Lewis Steele, Jr. and Gerald Jay Sussman. "The Art of the Interpreter or, the Modularity Complex(Parts Zero, One, and Two)". MIT AI Lab. AI Lab Memo AIM-453. May 1978.)'이라는 메모를 읽었는데, 그 장은 이 메모에 대한 훌륭한 보완이 됐습니다.

∗ 인터뷰에서 책에 빠져 있다고 말하는 부분은 Blue Book에서 볼 수 있다.

Part5: Fixed Point 계산과 고차 함수

2007년 8월 7일

Fixed Point 계산

함수를 반복적으로 적용하는 경우에 대해 생각해 보자. 함수를 여러 차례 적용하는 방식에는 반복(iteration)과 재귀(recursion)가 있다(재귀를 순환이라고 부르는 사람도 있다. 번역하는 사람들마다 다른 용어를 사용하는데 재귀와 반복을 되풀이와 되돌이로 표현하는 용례도 있다).

SICP의 시작부에는 제곱근의 해를 구하는 예제가 나온다. 제곱근을 구할 때 뉴튼 계산법(Newton's Method)을 사용하는 것으로 방정식의 해를 구하는 방법이다. 방정식은 뻔하다. 초기값 x 로부터 시작하여 방정식의 해를 근사법으로 추론하는 방법이다. 해는 x 의 값과 추론한 근사값의 중간에 있다고 가정하자. 만약 해를 구하는 함수가 있다고 하면 이 함수를 여러 번 적용하면 해를 구할 수 있을지 모른다. 문제는 이 예제가 어렵다는 것이 아니라 책의 초반부에 나온다는 점이다.

우선 SICP 책에서 루트를 구하는 간단한 코드를 보자. 이 코드는 근사치를 구하여 이 근사치의 제곱이 원하는 해에 근접하는지를 조사하는 것이다. 핵심적인 코드는 근사치 guess 가 원하는 값에 충분히 가까우면 guess 를 리턴하고, 아닌 경우 improve 로 guess 값을 계산하여 다시 자기 자신을 호출하는 5줄짜리 sqrt-iter 함수다. improve 는 x 와 guess 로 새로운 guess 값을 만든다.

(define (sqrt-iter guess x)

(if (good-enough? guess x)

guess

(sqrt-iter (improve guess x)

x)))

(define (improve guess x)

(average guess (/ x guess)))

(define (average x y)

(/ (+ x y) 2))

(define (good-enough? guess x)

(< (abs (- (square guess) x)) 0.001))

(define (sqrt x)

(sqrt-iter 1.0 x))

매우 간단하지만 상당한 정밀도까지 해를 구할 수 있다. SICP(http://mitpress.mit.edu/sicp/full-text/book/book.html) 1장에는 코드에 대한 자세한 설명이 나오고 뉴튼 계산법은 미적분학을 배운 사람들에게는 쉬운 문제다. 수치해석까지 공부한 사람들은 훨씬 많은 예들을 알고 있을 것이다.

>

>

그림 1. x=cos(x)의 그림

위의 식에서 중요한 것은 적당한 x에 대해 sqrt-iter를 여러 번 적용하면 해가 나온다는 것이다. 이런 예제들 중에 fixed point의 방법론을 적용하는 문제들이 있다. 그것은 f(x) = x 를 만족시키는 조건에서 초기값 x0 으로 시작한 문제들이 수렴하는 값 x 가 있다는 것이다. 그렇다면 반복적으로 함수를 적용할 때 다음은 어떤 값으로 수렴할 것이다.

>

>

경우에 따라 f는 아주 여러 번 적용될 수 있고 몇 번만 적용될 수도 있다. 때로는 무한정으로 적용될 수도 있을 것이다.

함수를 여러 번 적용하여 라디안으로 표현한 코사인 함수에서 x=cos(x) 를 만족하는 해를 찾는 것을 그림 1에서 보여주고 있다. 해는 중앙의 점으로 수렴한다(수렴은 리아푸노프 안정성이나 위상평면에서 해의 존재 유무나 궤적 문제로 복잡하게 풀어나갈 수도 있다). 어떤 시스템은 일정한 범위에서는 수렴한다는 것이 알려져 있다. 비슷한 예들은 매우 많으며 자연계에서도 관찰된다. 비선형 동력계 또는 카오스 패턴으로 나타난다. 로렌츠 어트랙터나 다른 여러 가지 스트레인지 어트랙터(strange attractor)들이 자연계에 존재한다는 것이 밝혀졌다. 해들은 특정한 값이나 일정한 범위에 있는 수많은 해를 갖는다.

수렴하는 조건이나 식들이 수식만이 아니라 기호나 집합일 수도 있다. 컴퓨터에서는 데이터들을 수렴하는 방법이 있을지도 모른다. 표현 방식은 여러 가지지만 단순한 반복문이나 재귀 코드나 다를 것이 없다. 여러 번 적용하는 것에서 일정한 패턴이 나오는 것을 기대할 수 있다. 만약 f가 수학의 함수가 아니라 리스프의 함수인 경우 재귀 형태나 반복 형태나 형식상의 큰 차이는 없다. 안에서 어떤 방법으로 구현되는지가 중요하다. f를 그냥 람다 함수라고 생각해도 마찬가지다. 또 어떤 함수를 fixed point로 만드는 변환 T를 만들고 새로이 변환된 함수가 수렴하기를 기대해 볼 수도 있다.

어떻게 보면 별다른 내용이 없는 수학 이야기 같지만 생각하기에 따라 생각할 거리를 던진다. 상징적으로 어떤 함수를 재귀적으로(또는 반복적으로) 사용하여 기호를 처리하거나 계산을 하는 것은 수렴 여부에 관계없이 다음과 같은 함수를 적용하는 하나의 패턴으로 생각해 볼 수 있다.

이런 방식으로 표현하면 평상시 사용하는 자바나 C++ 코드와는 다른 모습으로 생각해 볼 수 있다. 반복이나 재귀는 그저 함수를 여러 번 적용하는 것일 수 있다. 실제 코드에서 중간에 있는 f는 실제로 조건에 따라 내부의 함수 g나 h를 부를지도 모르며 리턴되는 값의 형태도 다양하다(fixed point의 성질과 적용에 대해 조금 더 생각해 보고 싶은 독자들은 서스만과 아벨슨의 강의 비디오 7a의 뒷부분을 보면 궁금증이 풀릴 것이다. Y 연산자의 문제나 fixed point가 수렴하는 문제들에 대한 통찰을 제공한다).

리스프 머신의 기본 아이디어

브라이언 하비(Brian Harvey)라는 해커가 있다(http://www.cs.berkeley.edu/~bh/). 1960년대 말 MIT 졸업 후 AI 연구소에서 일한 적이 있다. 현재는 버클리에서 강의를 하고 있다. 'Simply Scheme'이라는 책의 저자이기도 하다. 버클리 로고(LOGO) 개발자이기 때문에 로고에 관심이 있는 필자는 가끔 하비의 홈페이지를 들여다본다.

이번 글에 하비가 나온 이유는 SICP 강의를 하기 때문이다. 이 강의 동영상은 공개되어 있으며(이 글을 쓰는 현재 유튜브에서 볼 수 있다) SICP 저자인 서스만과 아벨슨의 강의와는 또 다른 느낌의 강의를 하고 있다. 서스만의 강의보다는 느슨하게 진행되지만 새로운 관점을 보여주고 있다. 하비의 강의를 보고 새로운 시각에서 스킴과 SICP를 바라보는 사람들도 있었다고 한다. 필자도 강의를 보면서 많은 것을 배웠다. 학부 저학년을 대상으로 하는 강의로 가벼운 마음으로 들을 수 있다.

강의 주제 'Interpreter'에서는 리스프의 인터프리터에 대해 설명한다. 한마디로 인터프리터는 만능 기계(universal machine)이라는 것이다. 필자의 첫 번째와 두 번째 글이 인터프리터를 만드는 것으로 시작했으므로 독자들은 람다 계산법을 실행하는 특이한 프로그램에 대해 이미 알고 있으며 함수 apply와 eval에 대해서도 이미 알고 있을 것이다.

그림 2에서 (lambda(x)(+ (* 2 x) 3)) 을 인터프리터가 읽으면서 람다를 수행하는 기계처럼 변하고 7을 받아 결과 값이 나오는 모습을 보여주고 있다. 인터프리터는 주어진 식에 따라 변신을 한다. 식을 읽은 인터프리터는 마치 (2x +3)을 수행하는 기계처럼 변신하는 것이다. ((lambda(x)(\plus (* 2 x) 3)) 7) 은 17 을 리턴한다.

>

>

그림 2. 람다식 그림

그림 2에서 칠판의 오른쪽 그림은 인터프리터 기계에 람다식과 계산할 값을 제공하는 개념을, 왼쪽 그림은 람다식을 읽은 인터프리터가 2x+3 을 계산하는 기계로 변한 것을 설명하고 있다.

그림 3은 식 (lambda (x) (+ (* 2 x) 3)) 을 cons cell 구조로 그려본 것이다. 당연히 식은 리스트 구조이지만 내부적으로는 이런 모습이라는 것을 보여주고 싶었다

>

>

그림 3. =(lambda (x) (+ ( 2 x) 3))= 리스트*

인터프리터 역시 지난번에 보았듯이 조금 커다란 리스트다. 리스트로 만들어진 리스프 인터프리터 기계는 리스트로 만들어진 식을 읽고 결과를 리턴한다. 이 시스템에서 모든 것은 리스트다. 자료구조 역시 간단한 아톰이 아니라면 리스트이며 결과 역시 아톰이 아니라면 리스트다. 변수표도 리스트이며 환경이라고 불리는 변수 값 찾아보기의 프레임들 역시 리스트로 표기한다(최적화를 위해 실제로는 리스트가 아니지만 리스트로 표기한다).

리스트를 읽고 리스트를 만들어내는 프로그램도 리스트이며 이런 일을 모두 주관하는 인터프리터마저 리스트다. 이미 만들어진 리스프의 인터프리터를 이용하여 다른 리스프를 만들어내는 메타서큘러 인터프리터 역시 새로운 리스트를 원래의 인터프리터가 읽고 만들어낸 또 하나의 리스트일 뿐이다. 그런데 그 리스트는 실제로 작업을 한다!

앞의 비유를 들자면 인터프리터 기계에 새로운 인터프리터 코드를 넣었더니 기계가 새로운 기계로 변신한 경우다. 그러니 만능 기계라는 말은 맞다. A4 1장으로 만든 개념적인 인터프리터 안에 내재된 특성치고는 놀라운 것이다. 그리고 람다 계산법의 특성에서 도출되는 결론이지만 코드와 프로그램은 잘 구분되지 않는다(연재 3회의 글 가운데 람다를 소개한 부분을 살펴보라).

고차 함수(Higher Order function)

SICP 책의 앞부분인 1.3에 나오는 글이면서도 상당히 어려운 부분이다. 우선 고차 함수라고 번역할 수 있는 이 함수는 하나 또는 그 이상의 함수를 인수로 취하거나 결과값으로 함수를 내어주어야 한다. 컴퓨터보다는 수학에서 더 적절한 비유를 찾을 수 있다. 미분연산자는 함수를 받아 다른 함수로 내어준다. 함수형 프로그래밍 언어에서 많이 쓰이는 map 함수 역시 고차 함수다. 이를테면 함수 f를 입력으로 받아 개별적인 요소들에 대해 계산한 결과 값을 돌려준다.

독자들도 알다시피 함수형 프로그래밍(functional programming)은 함수의 계산(evaluation)만으로 프로그래밍하며 상태(state)를 갖거나 데이터 값을 변경하지 않는 것이다. 간단히 말하면 함수형 프로그래밍에는 대입 연산이라는 것이 없다. 그러나 명령형 프로그래밍(imperative programming)은 상태 변화에 기반을 둔다. 리스프에는 원래 대입 연산이 없었다. 나중에 대입 연산이 구현되었으나 함수형 언어처럼 사용할 수 있다. 스킴 역시 마찬가지다.

고차 함수를 사용하면 함수 대입이나 변환에서 상당한 유연성을 제공하는 것이 분명하다. 여기에 든 예제들은 주로 수식 위주지만 기호와 리스트, 다른 함수가 제공하는 지연된 답들마저도 고차 함수를 이용하여 표현할 수 있다. 앞서 예를 든 반복문의 적용 패턴도 일종의 고차 함수처럼 바라볼 수 있다.

고차 함수의 정의와 무관하지 않은 몇 가지 패턴이 있다. 우선 프로시저가 다른 프로시저의 인자로 작용하는 경우를 생각할 수 있다. 다음 식은

>

>

아래와 같은 모습의 프로시저로 구성할 수 있다(공통된 패턴이 있다는 것은 유용한 추상화가 가능하다는 증거이기도 하다. 일단 양측을 잘 살펴볼 필요가 있다).

(define (sum term a next b)

(if (> a b)

0

(+ (term a)

(sum term (next a) next b))))위 식에서 term 과 next 는 함수이면서 실제로 함수의 인자이자 이름처럼 넘겨졌다. C와 같은 언어라면 함수의 포인터를 넘기는 것으로 비슷한 일을 할 수 있지만 제약이 있을 것이다. 리스프 계열 언어에서는 용법의 사소한 차이는 있어도 함수 그 자체가 다른 함수의 인자가 된다. 밑의 식은 1부터 10까지의 정수를 그냥 더하는 것이다. 제곱이나 세제곱 아니면 다른 복잡한 함수도 쉽게 적용할 수 있다. identity 대신 square 나 cubic 이 붙은 함수를 정의하고 적용하면 되는 것이다. term 과 next 에 해당하는 함수를 바꾸어주는 것만으로도 많은 일을 할 수 있다.

(define (inc n) (+ n 1))

(define (identity x) x)

(define (sum-integers a b)

(sum identity a inc b))그러면 (sum-integers 1 10) 은 55 를 리턴한다.

두 번째는 람다 함수 사용이다. sum 을 만드는 프로시저 코드 안에 직접 람다를 사용하여 좀 더 유연하게 프로시저를 만들 수 있다. pi-sum 은 a 에서 b 까지 계산마다 +4 씩 증가하고 이 값을 (lambda (x) (/ 1.0 (* x (+ x 2)))) 에 적용하고 결과를 더해가는 프로시저다.

(define (pi-sum a b)

(sum (lambda (x) (/ 1.0 (* x (+ x 2))))

a

(lambda (x) (+ x 4))

b))세 번째로는 프로시저를 일종의 메서드처럼 사용하는 방법이다. 프로시저가 다른 프로시저와 복합적인 방법으로 사용되는 것은 물론이고 다른 프로시저를 컨트롤하는 프레임워크가 되는 것이다.

네 번째는 프로시저의 결과 값 자체가 새로운 프로시저가 되는 것이다. 앞서 말한 것처럼 미분연산자를 통과한 함수가 전혀 다른 것이 되는 일 같이 어떤 프로시저는 입력으로 받은 프로시저 자체를 새로운 프로시저로 되돌린다. 지면상 이 방법의 예제를 적는 것은 생략하지만 SICP의 1.3.4에 간단한 예제가 있다. 만능 기계처럼 움직이는 인터프리터 예제도 이 범주에 속한다(사실 1.3을 한 번에 이해할 수 있다면 정말 지나치게 총명한 독자라고 할 수 있다. 이 장에는 보물찾기처럼 많은 것들이 숨어있다).

앞의 예들은 일반적 언어에서는 자주 사용되지 않는다. 강력한 권한 때문에 안전성이나 코드 효율 면에서 복잡한 문제들이 발생할 소지가 있다. 그래서 보통 프로그래밍 언어들은 조작되는 요소들에 제약을 걸고 있다. 가장 적게 제한 받는 요소들을 first-class의 요소들이라고 한다. first-class 요소들의 '책임과 권리'는 다음과 같다.

- 변수를 사용하여 이름을 부여할 수 있고

- 프로시저의 인자로 넘겨질 수 있으며

- 프로시저의 결과 값으로 되돌려질 수 있고

- 자료 구조 내에 포함될 수 있다.

독자들의 머리를 아프게 하기 때문에 좋은 예라고 볼 수는 없지만 SICP 1.3장은 뉴튼 계산법으로 제곱근을 계산하는 방법들을 여러 가지 방법으로 추상화하여 만들어낼 수 있음을 보여준다. 하나의 아이디어를 표현하는 여러 가지 우아한 방법이 있다는 것을 알려준다.

보충에 가까운 내용으로 피터 노빅의 글 'A Retrospective on Paradigms of AI Programming'에 있는 'PAIP로부터 배운 것들' 부분에서는 다음과 같은 내용이 일종의 교훈이라고 전한다. 모두 52개나 되지만 지금까지 이야기한 것과 관련이 있는 것은 몇 개 안 된다.

- 람다 함수를 사용하라(앞서 설명했다).

- 실행시에 새로운 함수(closure)를 만들어내라(closure는 다음 회에 설명할 강력한 프로그래밍 패러다임이다).

- 문제 해결에 가장 적절한 표기법을 사용한다.

- 여러 가지 프로그램에 같은 데이터를 사용한다.

- 구체적이어야 한다. 추상화를 사용하라. 간단해야 한다. 주어진 도구를 사용하라. 애매해지면 안 된다. 시종일관하라.

- 매크로를 사용하라(정말 필요한 경우에만).

- 20개 또는 30개 정도의 중요한 데이터 타입이 있는데 이들에 대해서는 잘 알고 있어야 한다,

위의 내용 중 클로저라는 것은 OOP에 나오는 개체의 인스턴스를 만드는 과정의 리스프 버전과 비슷하나 람다 함수의 특성을 이용한다. 지면상 다음 회에서 설명해야 한다.

>

>

다음 회에는 'GÖdel, Escher, Bach'라는 책에 대해 잠시 설명할 것이다. 상당히 어려운 책이지만 많은 컴퓨터 사람들의 영감을 자극했다(퓰리처상도 받았고 이미 고전이다). 책에는 여러 가지 테마가 섞여있지만 필자가 이야기하려는 것은 그 중의 일부만으로 내용 설명이 아니라 영감을 줄지 모르는 몇 가지 화두를 설명하기 위해서다.

>

>

그 다음은 해커들의 힘이라는 것이 결국 집단지능이라는 민스키의 이야기를 해야 할 것이다(사실 민스키와 매카시의 AI 연구소에 모여있던 프로그래머들을 해커라고 부르면서 해커리즘이 생겼다). 그리고 민스키를 소개하면서 그의 대표작인 'Society of Mind'를 이야기하지 않을 수도 없다. 이 책은 앞서 말한 'GÖdel, Escher, Bach'와는 또 완전히 다른 무엇이 들어있다.

Part6: 괴델, 에셔, 바흐 그리고 해커리즘의 쇠락

2007년 9월 18일

들어가며

지난번에는 람다에 대해 간단히 적었다. 람다 계산법이 이상하게 보인다 해도 너무 심각하게 생각하지 않아도 된다. 당장은 이해할 필요도 없다. 이해에는 많은 시간이 걸릴지도 모르며 이해하지 않아도 별 문제는 없을지도 모른다. 컴퓨터를 잘 몰라도 IT 개발 업무에 종사하는 사람이 상당수 있는 것처럼 람다를 잘 모른다고 큰 문제가 생기는 것도 아니다. 실제 코드를 짜는 일에 람다 계산법을 적용하는 일도 별로 없다. 리스프는 이미 람다를 충실하게 구현하고 있다.

필자의 임무는 리스프 여행 가이드이므로 너무 어렵지 않게 이야기를 적어 나가야 한다는 것을 안다. 읽다가 호기심이 생기는 부분이 있으면 찾아볼 자료들은 얼마든지 있을 것이다. 이번 이야기는 람다가 중요한 화두로 등장하는 역사적 사실의 배경이다. 그 시작은 서스만과 스틸의 스킴(Scheme)이 람다 페이퍼들과 함께 나왔고 람다 페이퍼가 나온 이유는 이들이 액터 모델(actor model)을 이해하고 싶어 했기 때문이다.

액터 모델은 칼 휴이트(Carl Hewitt)라는 총명한 학자가 제시한 모델이다. 사실 이번 이야기는 액터 모델보다도 휴이트가 주인공이다.

지난번에 람다와 프로세스에 대한 이야기를 했기 때문에 이번 주제는 복잡한 것들과 동시적인 것들에 대한 암시들이다. 다른 것들도 많겠지만 고전적인 것들을 꺼내 보았다. 필자의 책상 오른쪽 옆구리에는 오랫동안 놓여있는 책 몇 권이 있는데 가끔씩 꺼내 읽으면서 많은 생각을 한다. 실용적이지도 않으며 결론은 없지만 암시적인 임무는 충실히 하는 책들이다. 컴퓨터에 관련된 책 중에는 마빈 민스키의 『The Society of Mind』와 더글러스 호프스태터의 『Gödel, Escher, Bach』(이하 GEB)가 있다. 몽상가 기질이 있는 필자는 가끔 책에 나오는 구절들을 생각하며 묘한 상상을 하곤 한다. 책의 제목들은 화두라고 볼 수 있으며 상식적으로 생각하는 내용에 도전하기도 한다. 우리가 무엇을 안다는 것이 무엇인가에 도전하기도 하고 지능이라는 것이 무엇인가에 대한 화두도 던진다.

알 것 같기도, 모를 것 같기도 한 화두들은 전염성이 있으며 선승들이 몇 개의 화두를 붙잡고 고민하는 것처럼 머릿속에 오래 남아 오만 가지 생각을 불러일으키기거나 다른 아이디어를 싹 틔우기도 한다. 사람들은 화두를 갖고 생각과 논쟁을 거듭한다.

이상한 고리

출판된 지 거의 30년이 되었지만 이 책을 기억하는 사람들이 많고 아직도 팔린다. 이 책은 제목(Gödel, Escher, Bach) 그대로 세 사람의 생애와 작품들을 모아놓고 여러 가지를 보여준다. 형식적 규칙(formal rule)과 자기참조(self-reference)를 통해 의미가 없는 것들로부터 의미가 만들어지는 현상을 설명한다. 통신이라는 것과 지식을 전달하고 저장하는 방법들, 그리고 기호를 통한 표현의 한계를 설명한다. 이 책은 1999년 한국어판이 나왔다.

그림 1. GEB 표지

그림 1. GEB 표지

이렇게 어려운 주제를 다뤘지만 책이 인기를 얻은 것은 이들을 흥미롭게 설명했기 때문이다. 그래서 사람들은 이 책을 보고 많은 생각을 하게 되었다. 주제들은 우리의 생각과 주위에 흔한 것들이라 막상 생소한 것도 없었다. 생각을 글로 옮기고 철학적으로 생각하면 어려워진다. 말이라는 것이 원래 어려운 것이다. 책을 너무 심각하고 진지하게 생각하면 안 된다. 저자는 유희적 요소를 동원했다.

아킬레스와 거북(『이상한 나라의 앨리스』를 쓴 루이스 캐럴의 "거북은 아킬레스에게 무엇을 말했는가"에서 캐릭터를 따왔다) 그리고 게(바흐의 'crab canon'에서 따왔다)가 등장하고 이들이 나누는 대화가 책의 내용이다.

해커들이 오랫동안 프로그래밍의 요소를 놓고 고민했듯 철학자들은 자기참조라든지 형식적인 규칙들을 놓고 고민해왔다. 음악이나 미술에도 이런 요소들이 있다고 한다. 언어에도 있다. 나("I")는 자기참조적인 낱말이다. 자기참조라고 하니 철학적인 용어처럼 보이지만 프로그래밍에서는 언제나 접하는 요소다. 재귀(recursion)를 말한다.

그림 2. 자기참조를 상징하는 그림. Ouroboros라고 부른다. 자기 꼬리를 삼키는 뱀(또는 용)의 그림이라고 한다. (대체이미지)

그림 2. 자기참조를 상징하는 그림. Ouroboros라고 부른다. 자기 꼬리를 삼키는 뱀(또는 용)의 그림이라고 한다. (대체이미지)

몇 가지 요소를 잘 묶어 이들이 생기는 법칙을 부여하면 의미가 생긴다. 음표는 의미가 없지만 바흐가 이들을 묶어 악보로 만들어 놓으면 의미가 있다고 생각되는 음악이 나온다. 생성규칙 역시 지난 칼럼에서 이야기했다. 리스프의 리스트 표현에 앞서 설명한 s-expression이 생성규칙의 하나다.

GEB에 나오는 바흐의 카논과 푸가는 이것을 한층 더 발전시킨 것이다. 카논은 여러 개의 성부로 되어 있다. 이들은 마음대로 나오는 것이 아니라 주제는 제1성부에 있고 2, 3성부는 같은 주제를 반복한다. 카논은 주제를 스스로에게 다시 적용하는 것이라고 한다. 주제들이 화음을 이루는 법칙이 있기 때문에 음표는 하나의 선율의 일부이며 화성학적으로나 선율적으로 다른 방식으로 작용해야 한다. 듣는 사람은 이들의 연관관계를 파악하며 카논의 의미를 파악한다. 그러니까 정교한 프로그래밍과 다를 것이 별로 없다. 악보는 컴퓨터의 소스코드처럼 기록되며 이것을 연주하는 것은 컴퓨터가 소스코드를 실행하는 것과 같다.

의도적으로든, 의도하지 않든 사람들은 음표의 강약과 화음 속에서 음악에 푹 빠진다. 높은 집중도와 몰입 그리고 지적인 활동이 요구되는 활동인 것이다. 같은 일을 하는 여러 개의 쓰레드나 프로세스 활동처럼 각 성부의 악보는 빨라지기도 하고 느려지기도 한다. 바흐의 천재성은 6성부의 푸가도 만들어 낼 수 있었다(때로는 즉흥적으로 푸가나 카논을 만들기도 했다). 6성 푸가는 당시의 정신사에 깊이 관여한 프리드리히 대왕에게 헌정되었다. 고도의 인공물(artifact)인 음악은 사람들의 정신을 고양시키는 프로그래밍 활동으로 볼 수 있다. 카논이나 푸가를 들으면서 실제로 이런 일이 일어나는 경우도 있기 때문에 여러 개의 성부가 만드는 효과를 프로그래밍이라고 부르지 못할 것도 없다.

책의 다음 주제는 무한히 상승하는 것처럼 보이는 카논을 예로 든다. "무한히 상승하는" 카논은 C 단조에서 시작하여 D, E 단조로 조를 바꾸고 다시 정확히 C 단조로 돌아온다. 이 과정은 무한히 지속할 수 있을 것 같은 느낌을 주고 저자는 이상한 고리의 전조를 읽어냈다. 이상한 고리는 호프스태터가 최근에 쓴 책의 제목(『I am a Strange Loop』)이기도 하며 GEB를 관통하는 중요한 주제이기도 하다. 위계질서의 층위가 무한히 올라가거나 내려갈 것 같지만 예기치 못하게 위계질서의 층위는 처음으로 돌아오는 현상을 "이상한 고리(strange loop)"라고 불렀다. "헝클어진 위계질서(tangled hierarchy)"가 나타난다.

그래서 에셔가 나온다. 에셔의 그림들은 이율배반, 착시 또는 중의성에 기반을 두고 있다. 어떤 그림들은 때로 "이상한 고리"를 보여준다. 그림에 나오는 폭포는 단순한 고리이지만 몇 개의 층위가 나오는 그림들도 있다. 그 중 하나가 에셔의 손 그림이다. 그림에서 손은 다른 손을 그린다. 서스만과 아벨슨의 SICP 비디오 강의에서도 이 그림을 인용했다. 한쪽 손의 이름은 eval이고 다른 손에는 apply라고 적혀 있다. 어떤 것이 우선적인 층위인지는 애매하다. 리스프 인터프리터의 프로그래밍은 apply로 시작해도, eval로 시작해도 같은 결과에 도달했다(필자의 두 번째 칼럼에서 다루었다). 코드상으로는 eval이 더 높은 순위처럼 보이지만 아니다(더 많은 층위의 문제들도 있다. 그것은 책을 보는 수밖에 없다).

(대체 이미지)

(대체 이미지)

이율배반 논리에 대한 "이상한 고리"도 존재한다. 그것은 괴델의 불완전성 논리에 의해서였다. 앞에 나온 폭포가 "이상한 고리"인 것과 같이 괴델에 의해 수학적 논증 그 자체가 도마에 오르게 되었다. 결국 수학적 논증에도 같은 주제가 적용된다는 것을 알게 되었다(크레타섬 사람이 "모든 크레타인은 거짓말쟁이다"라고 말하거나 "이 명제는 거짓이다"라고 하는 명제 그 자체가 문제가 되겠다).

>

>

(대체 이미지)

GEB의 이야기 거리들

책을 다 소개한다는 것은 바보짓에 가까우니 두세 가지 주제만을 생각해 보자. 그냥 생각해보기만 하는 것이다.

1부의 6장 "정보는 어디에 자리잡고 있는가"에서는 음반의 골에 음악 정보를 담은 LP 음반과 전축을 예로 든다. 각각 정보 저장자(information-bearer)와 정보 발현자에 해당된다. 음반은 음을 충실하게 복원한다. 그러나 경우에 따라 정보를 정보 저장자에서 "꺼내는" 일에는 노력이 필요하며 정보를 꺼내기 위한 노력에 투입되는 정보가 정보 저장자보다 많은 경우가 있다고 한다.

컴퓨터를 하드웨어 입장에서 본다면 프로그램 파일로부터 실제 프로그램을 실행하기 위해 엄청난 노력을 해야 한다. 운영체제를 수행해 자원을 관리하고 프로그램을 읽어 일일이 수행시켜야 한다. 어쩌면 간단한 프로그램보다 더 거대한 시스템이 준비되어 있다고 볼 수도 있다. 모든 준비가 끝나야 프로그램은 제대로 수행될 수 있다. 라이브러리가 하나만 잘못되어도 문제가 나타나며 시스템이 수행하는 것이 애플리케이션에 있는 모든 정보도 아니다. 이렇게 생각한다면 정보가 어디에 있는지는 예상보다 어려운 문제다.

책에서는 DNA의 이중나선에 있는 정보의 발현을 다룬다. DNA의 정보는 (ATGC의 염기서열로 되어 있는) 일종의 리스트 구조처럼 보이는 자료구조다. DNA의 정보는 적절한 시기에 발현(revelation)된다. 바흐의 카논 악보가 악기의 소리를 내는 것과 비슷하지만 이 리스트는 수없이 많은 단백질을 만들어내고 이들의 동시적인 활동이 생명 활동이다. 하나씩은 어떻게 해석하더라도 이 암호가 다른 것들과 어떻게 통신하는가에 대해서는 잘 모른다. 그냥 기능한다는 것만 알 뿐이다. 몇 가지는 그 사이클이 밝혀졌음에도 불구하고 이들의 상호작용은 아주 복잡한 악보의 연주 활동이라고 말할 수 있다. 수백 수천 개의 성부로 구성되어 있는 악보와 마찬가지다. 이 악보는 설계자가 누구인지도 모르며 주석조차 달려있지 않다. 이 리스트는 전체가 다 필요한 것이 아니라 특정 부분들이 해석되며 시작과 끝은 일정한 염기 서열로 표시되어 있다. 그러면 인터프리터를 닮은 리보솜이 DNA를 복사하여 작업을 시작한다.

저자는 정보의 발현을 주크박스에 비교했다. 주크박스의 버튼을 누르면 음악이 연주된다. 그렇다면 세포는 거대하고 복잡한 주크박스라고 볼 수 있다. 단추의 버튼으로 트리거 된 기나긴 체인이 발동할 수도 있다. 그리고 이 체인은 다른 주크박스의 스위치를 트리거 하기도 한다. 주크박스의 출력이 발라드가 아니라 더 복잡한 주크박스의 제작법을 다룬 가사처럼 보일 수도 있다. DNA의 일부가 RNA로 전사되어 이 RNA로 단백질을 만들면 다른 스위치가 트리거 된다. 그래서 표현형은 잠재적으로 DNA에 잠재되어 있던 정보의 발현이라고 본다(이를테면 특정 부위의 몇 개의 염기서열은 대머리나 곱슬머리의 표현형을 만들 수도 있으나 표현형의 발현은 주위 환경이나 다른 유전자의 영향과 무관하지 않은 경우가 많다).

머리가 아파지기 시작한다. 그러면 DNA에는 생명에 관계된 모든 정보가 전부 포함되어 있는가? 그렇다고 볼 수도 있지만 아닐 수도 있다. DNA의 정보를 꺼내는 모든 과정은 DNA에 있는 것이 아니라 DNA 자체에는 코드화되어 있지 않은 세포 속의 복잡한 활동에 의해 일어난다. 그런데 그 세포는 DNA를 복제해 물려받으며 만들어진 것이다. 정보는 DNA에 있는가 아니면 다른 어디에 있는 것인가? 이들 모두인가? 닭이 먼저인가 달걀이 먼저인가처럼 이상한 고리가 있는 것처럼 보이지 않는가? 그리고 이 메시지는 보편성이 있는 메시지인가? 메시지의 층위는?

만약 이것이 컴퓨터 내부에서 발생하는 사건이라면 어쩌면 비교적 간단한 몇 개의 IPC나 RPC가 만들어지고 자동으로 트리거 되는 몇 개의 프로세스가 수천 개의 반응을 조절하는 것인지도 모른다. 만드는 일에 필요한 정보는 분석하는 일의 정보보다 훨씬 작을 수도 있다.

다른 문제는 층위에 관한 것이다. 10장의 기술층위와 컴퓨터 체계에서는 컴퓨터의 층위를 설명한다. 같은 장의 앞과 뒤 부분에는 많이 인용되는 '전주곡(prelude)'과 '개미 푸가'가 소개된다. 이 장은 사회생물학으로 유명한 E. 윌슨이 직접 초고를 읽고 감수해 주었다고 한다. 나중에 유전자 알고리즘을 만든 존 홀랜드에 의해 여러 번 다시 인용되었다.

'전주곡' 부분에서는 전주곡이나 푸가의 한 성부 역시 하나의 곡이라고 할 수 있다. 등장인물들은 이들을 개별적으로 따라가면서 전체를 듣는 것이 가능하지도 않으며 반대로 전체를 들으며 개별적인 성부를 듣는 것이 가능하지도 않다는 것을 이야기한다. 그럼에도 음악을 감상할 수 있는 것은 두 가지를 무의식적으로 또는 자연스럽게 오가기 때문이라고 이야기한다. 분명히 하나의 성부와 다른 성부들을 같이 듣는 것은 다른 일이다.

층위가 저절로 생기는 것은 아니다. 무엇인가에 의해 만들어진다. 예를 들어 운영체제의 층위는 프로세서 안에 있는 개개의 트랜지스터보다는 훨씬 위에 있다. 컴퓨터는 사람들이 거의 모든 것을 다 알고 있다고 생각해도 모르는 부분이 많아진다. 밖에서 보면 하나의 생물처럼 보이는 개미 군집은 작은 로봇과 같은 개미로 만들어져 있다. 개미들은 미약하고 지능이 없지만 개미 군집은 훨씬 더 많은 일을 할 수 있다.

개미핥기, 게, 아킬레스 그리고 거북이가 나온다. 이들의 대화가 개미들의 푸가와 오버랩되며 이야기가 진행된다. 이들은 처음에 전일주의(holism)와 환원주의를 놓고 입씨름을 벌인다. 전일주의는 전체가 그 부분들의 합보다 크다는 생각이며 환원주의란 각 부분과 그 '합'의 본성을 알아야만 전체를 알 수 있다는 생각이다. 개미는 컴퓨터의 트랜지스터처럼 생각해 볼 수 있다. 비교적 동작을 잘 알고 있기 때문에 개미를 잘 안다는 생각이 들고 이들이 하는 일 역시 잘 알려져 있지만 전체로서의 개미 군집은 이들의 모습과 다르다(가끔 물방울과 파도는 다르다는 식의 표현을 쓰기도 한다).

개미핥기는 환원주의자로 등장한다. 그러면서 자기는 개미 군락에 대한 신경외과 의사로 자처한다. 개체인 개미들은 개미핥기가 먹어 치우지만 개미 군락의 이상한 신경증상이 좋아진다고 주장한다. 더군다나 개미 군락에 하나의 인격체처럼 이름을 붙이기도 한다. 개미핥기는 개미를 마구 잡아먹는다는 다른 대화자들에게 한 개미 군락을 핥아먹었던 일을 힐러리 아줌마와 재미있게 대화했다고 이야기했다. 정말 대화는 즐거웠다는 것이다.

모두 경악하는 가운데 개미핥기는 자신의 기술이 오랜 훈련과 관찰 끝에 얻어진 숙련된 기술이라고 말한다. 개미 한 마리에게는 무서운 일이겠지만 자신은 개미의 카스트(개미들끼리의 신호를 통해 만들어진 카스트)에 새로운 질서를 부여했다고 말한다. 개미 군락의 업그레이드이며 "하나의 지식조각"을 만들어 주었다고도 말한다. 필자는 하나의 악보의 음표와 같은 개미와 성부와 같은 카스트 그리고 전체 악보와 같은 군락의 모습을 떠올린다. 이들은 모두 의미가 있다. 카논이나 푸가와 마찬가지로 책을 읽다 보면 떠오르는 이상한 마음속의 그림에 독자들이 흥미를 느낄지도 모른다(서점에 있는 호프스태터의 『이런 이게 바로 나야!』라는 책에 '전주곡'으로 나와 있는 부분만 읽어도 될 것이다. 읽어보면 많은 생각을 할 수 있다).

우리가 작업하는 층위는 컴퓨터에서 어느 정도 위치가 될 것인가를 생각해 볼 수 있다. 컴퓨터는 네트워크로 물려 컴퓨터 군락의 일부가 된다. 어느 정도의 카스트에 살고 있는지 한번 생각해 보는 것도 재미있을 것이다.

>

>

The Society of Mind

GEB 서문에는 책에 깊은 영향을 준 사람의 하나로 마빈 민스키가 나온다. 존 매카시와 테리 위노그라드는 책의 조언자로 나온다. 민스키의 대중적인 책을 이야기할 때도 되었다. 민스키의 대중적인 책은 『The Society of Mind』였다. 민스키는 마음이 없는 에이전트(agent)들이 모여 마음이 만들어진다고 보았다. "복잡한 모든 것은 서로 통하지 않는 부분들로 해체되어야 한다", "걷는 것을 통제하는 뇌의 부분은 집으로 걸어가는 것인지 일하러 가는 것인지 알고 싶어하지 않는다"와 같은 아리송한 이야기들을 말해왔다.

1970년대 초기에 민스키와 페퍼트는 『The Society of Mind』의 이론을 형식화하기 시작했다. 어린이 심리(developmental child psychology)에서의 통찰력과 경험을 AI 연구와 결합하려는 것이었다. 『The Society of Mind』에서는 지능(intelligence)이라는 것이 하나의 메커니즘의 산물이 아니라 다양한 종류의 에이전트들간의 상호작용에 의해 이루어진다고 제안한다. 다른 작업들은 근본적으로 다른 메커니즘을 요구하기 때문에 다양성이 필요하다고 주장하였다.

과학에서는 환원주의자가 우세하지만 현실에서는 여러 가지 이론과 법칙 같은 것을 만들어내는 소설가가 이겼는데 그 이유는 현실에서 작용하는 법칙이 과학 법칙보다 많기 때문이라고 했다. 우리가 지능이라고 생각하는 것의 정의가 항상 변하는 것이고 지능이라고 부르는 것을 만들어 내려면 법칙이 과학에서 생각하는 것보다 더 많다는 것이다. 과학자나 엔지니어는 가급적 간단한 법칙으로 설명하기를 좋아한다. 현실은 그렇지 않다. 얽혀있어서 원인과 결과와 법칙은 애매하다. 지능은 이런 곳에서도 돌아가야 한다.

1986년에 민스키는 『The Society of Mind』를 출간하였는데, 그 책에서는 하나의 페이지에 완결된 에세이가 270쪽에 걸쳐 서로 연결되어 있어서 민스키의 아이디어 구조를 반영하였다. 각 페이지는 어떤 심리적 현상을 설명하기 위해 하나의 메커니즘을 제안하거나 다른 페이지에서 제안한 해결책 도입에 필요한 문제를 제기한다. 책은 정식으로 출판되기 전에 초고들을 넘겨주었기 때문에 출판되기도 전에 여러 곳에 인용되었다. 민스키는 단편들로 이루어진 책을 사람들이 싫어한다고 말했다. "사람들은 줄거리가 없다는 이유로 그 책을 싫어합니다", "줄거리가 없다는 것이 줄거리입니다" 그것은 마음이나 정신처럼 독립적인 능력이 모여있는 것이라고 설명했다. 그러니 필자처럼 이 책이 재미있다고 생각하는 사람에게는 문제될 것이 없다. 그럼에도 불구하고 생각할 것은 많은 책이다. 독자를 놀라게 만드는 글귀들은 도처에 널려있지만 다음과 같이 말한 적도 있다.

"지능을 만드는 마술과 같은 트릭은 무엇인가? 그 트릭은 바로 아무런 트릭도 없다는 데 있다. 지적인 힘은 방대한 다양성이 그 바탕이며 어떤 완전한 단일 원리가 바탕이 아니다."

그렇다면 인공지능 책들이 점차 두꺼워지는 것도 이해가 간다. 인공지능이라고 부르는 것들 역시 지능처럼 필요에 따라 여러 가지로 정의할 수 있다.

그 다양성을 뒷받침하는 것은 자연에서는 쉽게 복제되어 엄청난 수를 자랑하는 생물들이다. 이들은 어떤 방법으로든 서로 연결되어 있는 긴 영향력의 팔을 갖고 있다. 서로 연결되어 클러스터처럼 일정한 일을 하는 조직을 만들어내기도 하고 생각하는 조직을 만들어 내기도 하며 가르쳐 준 것도 아닌데 생각을 하기 시작한다. 아마 프로그래밍으로 이런 것들을 만들어 낼 수 있다면 재미있을 것이다.

민스키의 어록은 끝이 없겠지만 1980년대에 앨런 케이와 비바리움 프로젝트를 진행할 때 이런 말을 한 적도 있다고 한다. 비바리움은 가상의 세계에서 생물을 시뮬레이트하는 프로젝트였다. "나는 엉성한 수정 프로그램에 찬성합니다. 버그를 발견하면 그것을 고치지 마십시오. 또 다른 코드를 써보고 버그가 발생하는가를 보고 그를 단념하십시오. ... 코드를 생물학적으로 소거하는 것은 비겁한 방법으로, 그것이 죽음이라는 것을 여러분은 알고 있습니다. ... 죽지 않는 것의 문제는 무한한 버그를 만든다는 것입니다."

재미있다고 생각할 수 있다(실제로 생물들은 끊임없이 이런 일을 반복하고 있다). 아무튼 해커리즘의 전성기는 이런 재미있는 사람들이 많던 시절이었다. 민스키는 초기 해커들이 있던 연구실의 책임자였다.

다시 해커리즘으로 돌아와: 집단 해커리즘과 리스프

스티븐 레비가 쓴 『해커』의 1부는 다음과 같이 시작한다.

그들은 9층의 테크스퀘어 시절을 해킹의 황금시대라 불렀다. 대부분의 시간을 우중충한 기계실과 근처의 사무실에서 보냈다. 그들은 터미널 근처에 바짝 모여 앉아 터미널에 줄지어 나타나는 초록색 코드의 문자열을 바라보면서 셔츠 주머니에 꽂혀 있던 연필을 꺼내 들고 프린트되는 출력용지에 표시를 하면서 자기들만의 은어로 무한루프나 잘못된 서브루틴에 대해 떠들어댔다.

방을 가득 메운 이 기술의 수도승 무리들은 그 어느 때보다도 낙원에 가까이 다가가 있었다. 이들의 이타적이고 무정부주의적인 태도야말로 생산성과 PDP-6에 대한 열정을 높일 수 있는 힘이었다. 예술과 과학 그리고 놀이가 한데 어우러져 프로그래밍이라는 마술적 행위로 녹아 들어갔다. 이 과정에서 해커들은 컴퓨터 안에서의 정보흐름에 대해서는 전지전능한 달인의 경지에 이르렀다. 이것은 다른 의미에서 (프로그래밍뿐만 아니라) 자신들의 삶 속에 포함된 모든 오류까지도 자랑스럽게 수정해내는 과정이기도 했다.

그러나 해커들이 '현실세계'라는 감상으로 뒤덮여 있는 시스템으로부터 아무런 간섭도 받지 않고 그들의 꿈을 삶을 살아가려는 한 그들의 꿈은 실현될 수 없었다. 그린블러트와 나이트가 자신들의 비호환성 시분할 운영체제(ITS)가 우월하다는 것을 외부인들에게 알리는 데 실패한 예는 작은 한 그룹의 사람들이 해커 주위에 몰입된다 해서 모든 해커들이 기대하고 있는 거대한 규모의 변화를 이루어낼 수 없다는 것을 말해주는 좋은 보기였다. 사람들은 컴퓨터를 해커들과 같은 열정으로 바라보지도 않았다. ...

또 해커들의 의도를 바람직하거나 이상적인 것으로 보지도 않았다.

민스키와 함께 AI 연구소를 이끌던 세이무어 페이퍼트는 나중에 『미디어랩』의 저자 스튜어트 브랜드에게 다음과 같이 말했다.

"해커들은 컴퓨터 과학의 전선을 창조해내고 있었습니다. 설계 내역도 없이 그들은 빠르고 지저분하게 프로그램 작성을 시도합니다. 최초의 컴퓨터 그래픽과 최초의 워드프로세서, 최초의 컴퓨터 게임 그리고 최초의 시분할 방식을 만들어냈습니다. 그들에게 무엇을 해보라고 해야 먹혀 들지 않았습니다. 하지만 관심을 끌 수는 있지요."

이들은 컴퓨터에 헌신한 집단으로 볼 수 있다. 특별한 보상이 주어지지 않았음에도 불구하고 초기 해커들은 컴퓨터를 사용하면서 황홀해했다. 자신이 하고 싶은 일에 충실한 해커들을 민스키는 "영웅"이라고 불렀다.

그러나 초기의 집단정신이 점차 퇴조하기 시작했다. 1980년대가 되면서부터 무엇인가를 개발하면 돈이 된다는 것을 안 해커들이 연구소를 떠나기 시작했다. 자신이 하고 싶은 것을 계속하는 해커들은 줄어들었다. 해커들의 황금시대는 PDP-6과 그 PDP-10과 같은 컴퓨터에서 일어났다. 세월은 바뀌고 있었다. 1세대 해커들이 컴퓨터에 빠져있던 기간에도 세상은 빠르게 변했다. 많은 알고리즘과 인공지능 프로그램이 나왔으나 그것은 시작이었다. 해커들이 만든 프로그램은 '빠르고 지저분하게' 세상에 태어날 수 있었으나 그 뒤에 숨어있는 프로그래밍의 요소들은 역시 나름대로 어렵고 복잡한 문제들이 숨어있었다. 컴퓨터 과학이 빠르게 발전함에 따라 열정적으로 추구했던 프로그램 만들기가 결국 하나의 프로그래밍 도구를 만드는 수준이라는 것을 깨닫고 만 해커들도 있었다. 이들의 역할은 군사작전의 교두보 확보와 같은 것이었는지도 모른다.

1980년대가 되자 몇 명 남아있지 않은 해커들마저 빠져 나갔다. 리스프 머신 상용화를 놓고 벌인 싸움 때문에 그나마 AI 연구소에 남아있던 해커들이 양분되었기 때문이다. 당시 리스프 머신은 적당한 가격에 비교적 좋은 성능의 워크스테이션을 제공할 수 있었기 때문에 주문이 밀릴 정도로 인기가 좋았다. 해커들이 리스프가 가장 효과적으로 수행될 수 있도록 설계한 기계인 리스프 머신이 잘 팔리자 해커들의 창조성을 상업화하여 창조성을 살리면서도 돈도 잘 벌 수 있는 회사를 만들면 어떨까 하는 아이디어가 나오면서 해커들이 양분되었다. 그 후 리스프 머신도 인기가 떨어지자 사람들은 뿔뿔이 흩어졌다. 두 회사 어디에도 속하지 않은 사람은 민스키와 스톨만 정도였다. 집단적인 정신도 흩어졌다.

리스프 머신의 운영체제 ITS의 작성언어인 리스프의 운명도 달려있었다. 리스프 머신의 인기가 시들해지자 리스프는 시스템 언어가 아니라 시스템에서 돌아가는 언어의 하나가 되었기 때문이다. 폴 그레이엄은 언어의 인기에 대해 말했다(http://www.paulgraham.com/popular.html). 프로그래밍 언어의 인기에 영향을 미치는 외부 요인 하나를 인정하면서 시작해 보자. 인기를 얻기 위해 프로그래밍 언어는 인기 있는 시스템의 스크립트 언어(scripting language)가 되어야 한다. 포트란과 코볼은 초창기 IBM 메인프레임의 스크립트 언어였다. C는 유닉스의 스크립트 언어였다.

리스프는 크게 인기 있는 언어가 아니다. 그것이 크게 인기 있는 시스템의 스크립트 언어가 아니기 때문이다. 지금 인기가 남아 있다면 그 역사는 그것이 MIT의 스크립트 언어였던 1960년대와 1970년대로 거슬러 올라간다. ...

프로그래밍 언어는 고립하여 존재하지 않는다. '해킹하다'는 타동사이다. -- 해커는 보통 무엇인가를 해킹한다. -- 실제로 언어들은 무엇을 해킹하는 데 쓰이는가에 따라 판가름 난다. 그래서 인기 있는 언어를 고안하고 싶다면, 언어 외에 다른 것들도 공급하거나, 그 언어가 기존 시스템의 스크립트 언어를 대체하도록 고안해야 한다.

리스프는 한때 중요한 도구였고 많은 사람들이 리스프로 꿈꾸고 리스프로 숨 쉰 적이 있었다. 그만한 도구가 없었기 때문이다. 지금은 리스프의 힘은 상대적으로 줄어들었다. 리스프 커뮤니티는 예전의 힘을 찾지 못하고 있다. 결정적인 이유는 아직 사람들을 다시 끌어 모을 특별한 계기가 없기 때문이다. 사람들은 프로젝트의 성공이 장비의 성능이나 대수가 아니라 참여한 사람들의 열정과 관심에 좌우된다는 것을 알고 있었다. 결국은 사람이 먼저 프로그래밍되어야 한다고 생각할 수 있다. 개미의 푸가처럼 말하면 많은 악보가 활발하게 연주되는 상황이 되어야 집단지능의 힘이 나온다.

리스프가 요즘은 별로 인기가 없음에도 불구하고 리스프를 소개한 이유는 아직도 SICP처럼 훌륭한 책들이 교과서로도 쓰이며, 리스프에 관심을 가진 사람들이 있다고 생각하기 때문이다(민스키는 다양성이 지능의 근본이라고 말했지 않은가?). 리스프만의 강력한 표현력과 상상력이 필요한 부분도 있고 리스프를 통해 구현된 도구도 많이 남아있다. 직접 사용하지는 않더라도 리스프를 이해하면서 얻을 수 있는 것이 많다고 생각했기 때문이다.

필자가 독자들에게 바라는 것은 호기심 또는 관심이다.

컴퓨팅 기술의 원형 탐험

저자 안윤호

Part1: 간단한 레지스터 머신에서 시작해 보기

2008년 3월 18일

들어가며

지난해 썼던 「해커 문화의 뿌리를 찾아서」에서는 해커와 리스프(LISP) 구현 이야기를 하다가 『괴델, 에셔, 바흐』와 『Society of Mind』라는 책을 소개하는 것으로 매듭지으면서 그 이야기들이 하나의 화두 역할을 하기를 바라는 소망적인 생각을 전했다.

「해커…」의 주제가 된 SICP는 『컴퓨터 프로그램의 구조와 해석』이라는 제목으로 책이 번역, 출판되었으니 관심 있는 독자들은 원서와 같이 읽어보아도 좋을 것이다. 필자는 때로 번역이 참으로 편리함을 주는 수단이라는 생각을 한다. 일정 수준 이상의 번역은 아무래도 술술 읽히는 신비한 능력이 있다. 그래서 번역이 중요하며 책의 번역이 일어나면 읽는 사람도 늘어나며 동시에 관심이 있는 사람도 늘어난다. 책의 내용을 떠나 책 자체가 논의나 토론의 대상이 되기도 한다. 그래서 필자는 SICP 번역이 중요한 의미가 있다고 믿는다.

「해커…」의 주제가 된 SICP는 『컴퓨터 프로그램의 구조와 해석』이라는 제목으로 책이 번역, 출판되었으니 관심 있는 독자들은 원서와 같이 읽어보아도 좋을 것이다. 필자는 때로 번역이 참으로 편리함을 주는 수단이라는 생각을 한다. 일정 수준 이상의 번역은 아무래도 술술 읽히는 신비한 능력이 있다. 그래서 번역이 중요하며 책의 번역이 일어나면 읽는 사람도 늘어나며 동시에 관심이 있는 사람도 늘어난다. 책의 내용을 떠나 책 자체가 논의나 토론의 대상이 되기도 한다. 그래서 필자는 SICP 번역이 중요한 의미가 있다고 믿는다.

지난해 연재에서는 시작하면서 「The Root of LISP」라는 글을 재료 삼아 리스프 인터프리터를 만드는 방법을 설명했는데 이는 역사적으로도 리스프 언어의 시작이었다. 매카시는 포트란에서 자극을 받아 람다(lambda) 계산법을 실행하는 방법을 생각하기 시작했고 그 생각이 실제로 구현되었던 것이다.

이 주제가 SICP 4장을 중심으로 한 메타서큘러 계산기(metacircular evaluator)의 실제 골격이다. SICP를 학교에서 가르칠 때 1장에서 3장만 가르치는 관행으로 볼 때 약간 파격적인 구상이나, 반대로 독자들이 다른 접근법을 통해 통찰력을 갖고 리스프를 바라볼 수 있다고 생각해 적어 보았던 것이다. 리스프에 관심이 있는 독자들은 지난 연재 1회와 2회 내용을 (다시) 읽어 보기를 바란다.

이번 연재는 비슷한 주제의 반복이다. 그러나 조금 현실적인 목표를 잡아 잘 다루지 않지만 중요하다고 판단되는 주제들을 생각해 보려 한다. 그 주제들은 레지스터 머신, 상태(state), 컨티뉴에이션(continuation), 클로저(closure) 같은 것들이다. 어려운 것들이라 깊이 들어가지 않고 중요한 주제의 화두와 그림을 제시하고 간단한 설명을 더하는 수준이 될 것이다. 이해가 잘 되지 않아도 너무 걱정할 필요는 없다. 원래 쉬운 주제가 아니기 때문이다. 그러나 이 용어들이 무엇인지 알아둘 필요는 있으며 생각할 거리로만 남겨두어도 된다(교양 과목처럼 생각해도 된다. 교양 과목은 중요한 주제를 다루지만 이를 아주 심각하게 받아들이는 순진한 사람들은 별로 없기 때문이다). SICP 책을 이해하기 위해 필요하기도 하지만 두고두고 생각할 주제가 되기에 충분한 중요성이 있다.

레지스터 머신 단순하게 보기

SICP 5장 제목은 '레지스터 기계로 계산하기'다. 책의 지은이들은 이 기계를 설계한 이유가 일종의 신비(mystery)를 풀기 위한 것이라고 말한다. 신비라는 것은 잘 알 수 없는 일들이 일어나는 것이다. 원인과 결과의 인과 관계가 복잡해 보일 때가 그렇다.

이때는 문제들을 단순화해 바라볼 필요가 있다. 지난번의 리스프 계산기(evaluator)는 그 자체가 다른 리스프 위에서 구현된 것으로 자세한 부분은 눈에 보이지 않는다. 그래서 신통하게도 A4 한 장도 안 되는 소스 코드로 매카시의 코드를 구현했다. 그러나 정작 최초의 구현을 맡은 프로그래머는 엄청난 양의 어셈블리 작업에 매달렸다. 하부를 이루는 apply의 마지막 부분들을 모두 손으로 만들어야 했던 것이다. 그러니 마법은 없었다. 신비스럽게 보이는 재귀(recursion)나 apply, eval 모두 마지막에는 기계어로 만든 낮은 레벨의 함수에서 실행되어야 했던 것이다.

신비로운 부분을 없애려면 어셈블리나 기계어로 바꾸는 과정으로 마지막 부분을 설명할 수 있을 것이다. 기계마다 하드웨어가 다르나 본질적인 요소는 실제로 간단하다. 그래서 등장하는 레지스터 기계는 이 계산기를 더 낮은 수준으로 구현하기 위해 만든 가상의 기계다. 몇 가지 기계 요소의 동작을 정의하는 것이 레지스터 기계 설계의 시작이다. 추상적이지만 중요한 부분을 모두 보여주는 편리한 교재이기도 하다.

당연한 것이지만 신기하게 문제를 푸는 정교한 알고리즘도 끝에 가면 수없이 많은 단순한 기계적인 조작의 연속이자 합으로 되어 있다. 독자들은 레지스터 기계를 살펴보는 것으로 반복(iteration)과 재귀의 차이를 알 수 있고 continue 레지스터와 스택(stack)을 이용하는 방법의 차이도 알 수 있다. 기계어를 따로 배우거나 기계어 코드에 정통하지 않아도 핵심 부분을 배우는 데는 지장이 없다. 따라서 레지스터 머신은 좋은 비유이자 모델이다. 조금 더 비유를 하자면 하노이의 탑(tower of hanoi)과 같은 수학적 예제가 있다. 알고리즘을 배우는 시간에 재귀 문제의 모델로 곧잘 등장한다. 복잡하게 보이는 고리 옮기기는 끝에 가서는 단순한 기계적 옮기기로 변한다. 정교한 알고리즘이나 복잡한 프로그램도 끝에 가서는 레지스터나 스택에서 순수하게 기계적인 조작을 하는 단순한 조작으로 변한다. 그렇지 않으면 연산이 일어나지 않는다. 그러니 끝까지 도달하면 신비는 없어지는 셈이다.

SICP 5장은 레지스터 머신을 정의해 밑바닥에서 일어나는 일들을 정의하는 작업과 리스프 언어 구현을 통합하는 작업을 그려보는 큰 그림을 그리고 있다. 어셈블러도 만들고 컴파일러도 만들며 인터프리터와 분석기(analyzer)도 다룬다. 그리고 결국은 언어를 실행하는 하나의 완결된 주제를 다루게 된다. 이른바 대통합인 셈이며 커다란 도전이기도 하다.

5장 시작은 매우 간단한 기계를 생각하면서 시작한다. 레지스터 머신이다. 간단하게 접근할 수 있는 몇 개의 저장소(register)를 사용하는 기본적인 방법을 그려보고 있다. 그림 1은 책의 5.1장에 나오는 GCD(최대공약수)를 구하는 기계의 그림이다. 알고리즘은 a를 b로 나눈 나머지가 0이 될 때까지 같은 작업을 되풀이(반복: iteration)하는 알고리즘을 기계로 구현해 본 것이다(책의 원문은 http://mitpress.mit.edu/sicp/full-text/book/book.html 에서 읽어 볼 수 있다).

>

>

그림 1. GCD를 구하기 위한 데이터패스의 그림

(define (gcd a b)

(if (= b 0)

a

(gcd b (remainder a b))))GCD 기계는 별다른 것이 없다. 기계는 같은 동작을 되풀이한다. a를 b로 나눈 나머지를 t에 저장하고 이 임시 결과의 값은 b로 옮긴다. b는 a로 이동한다. 반복 동작으로 나머지가 0이 되도록 기계적으로 계산할 따름이다. 나머지가 0이 되면 a가 최대공약수가 되는 알고리즘이다.

>

>

그림 2. GCD 기계의 컨트롤러 그림

기계는 크게 두 가지 요소로 나눌 수 있다. 일종의 설비나 부품과 같은 레지스터 a, b, t와 중간의 데이터 흐름을 제어하는 밸브 역할을 하는 a←b, b←t, t←r 같은 것들로 이들을 데이터패스(data path)라 부른다. 그리고 어디엔가 이들을 제어하는 제어기(controller)가 있다. 그림 2가 제어기의 그림이다. 간단한 플로 차트로 되어 있다. 그림 3은 서스먼과 아벨슨의 강의 동영상 9a의 화면으로 데이터패스와 컨트롤러의 관계를 보여주고 있다. 이 추상적인 기계의 요소들은 모두 정의가 가능하다. 정의된 소스 코드는 쉬운 내용으로 책의 5.1에 나온다. 필자는 이 부분을 다룬 지은이들의 동영상 9a를 한번 보기를 권장한다(동영상을 받을 수 있는 곳은 http://swiss.csail.mit.edu/classes/6.001/abelson-sussman-lectures/ 다).

>

>

그림 3. GCD 기계의 데이터패스와 컨트롤러의 관계를 설명하는 서스만

그림 4는 팩토리얼을 구하기 위한 코드를 구현하고 있다. 팩토리얼 코드는 다음과 같다.

(define (factorial n)

(if (= n 1)

1

(* (factorial (- n 1)) n))) >

>

그림 4. 팩토리얼을 구하는 기계의 데이터패스. 스택과 continue 레지스터와 관련된 데이터패스가 추가되었다.

이 코드를 구현하는 그림에서 앞의 GCD 기계와의 중요한 차이는 스택을 구현한다는 점이다. 스택이 있으면 스택에 데이터 값을 저장할 수도 있으며 저장할 수 있는 값 중에는 컨트롤러가 되돌아올 장소를 저장할 수 있다. 그래서 continue라는 레지스터가 도입되는데 이 레지스터는 goto 명령을 수행하기 위한 장소를 지정하고 저장된 몇 개의 label 사이를 오간다.

GCD와 팩토리얼의 코드는 차이가 거의 없다. 그러나 팩토리얼의 코드는 중간 계산값과 n을 저장해야 하는 문제가 있다. 그래서 데이터패스는 그림 4처럼 조금 복잡하게 변했다. 복잡하게 변하는 이유를 책의 구절을 인용하면 다음과 같다.

팩토리얼의 경우 팩토리얼을 구하는 문제의 일부분으로 안에 있는 팩토리얼 값을 구해도 이 값은 원래 구하려 한 팩토리얼 값이 아니다. n!을 구하려면, (n-1)!에 n을 곱해야 한다. GCD 설계를 흉내 내서 n 레지스터 값을 하나씩 줄여 팩토리얼 기계를 되풀이해서 돌리는 방법으로 풀려고 한다면, 다음 단계에서 n은 이미 바뀌어 버렸기 때문에, 결국 결과를 구할 때 곱해야 하는 예전 n 값을 쓰지 못한다. 따라서 안에 있는 문제를 푸는 팩토리얼 기계를 따로 만들어야 한다. 이렇게 따로 만든 팩토리얼은 또 다시 그 안에 있는 팩토리얼 문제를 풀려고 또 다른 팩토리얼 기계를 만들어야 한다. 이런 방법으로 계속해서 각각의 팩토리얼 기계는 안에서 다른 팩토리얼 기계를 만든다.

장황한 설명처럼 들리지만 기계를 여러 벌 만들면 해결되는 문제다. 그런데 필요한 기계를 여러 벌 만드는 것은 항상 어렵거나 불가능했다. 과거에는 어려운 문제였지만 튜링머신의 아이디어가 나온 이후에는 간단한 기억장치를 이용하는 것으로 문제들을 해결할 수 있다는 것을 알게 되었다.

보통 이런 문제는 스택을 사용하여 해결한다. 스택에 데이터를 저장하고 정확히 되돌릴 수만 있으면 한 벌의 설비(데이터패스)로 많은 계산을 할 수 있기 때문이다. 스택이 무엇인지 모르는 사람은 별로 없겠지만 스택 사용 방법이 쉬운 것은 아니다. 반드시 자료구조로서 스택으로 한정할 것도 아니다. 하지만 필요한 데이터는 어떠한 형태로든 저장되어야 한다(스택은 컴퓨터가 나오고 10년 정도 지난 후 발명되었다).

예제의 팩토리얼 계산은 서브루틴을 풀듯이 해결한다. 이 방법은 제어기가 안에 있는 문제를 풀고 난 다음, 원래 문제를 이어서 풀려고 할 때, 알맞은 명령 위치로 되돌아갈 목적으로 continue 레지스터를 사용한다(continue는 C 언어의 label과 goto라고 생각하면 된다). continue 레지스터에 저장된 엔트리 포인트로 돌아가는 팩토리얼 서브루틴을 만들 수 있다. 서브루틴이 호출될 때마다 n 레지스터와 continue를 저장(아래 소스 코드의 save 명령으로 push와 같다고 생각하면 된다)하고 나중에 값을 되돌릴(소스 코드의 restore로 pop과 같다) 수 있다. 계산의 '단계'마다 continue 레지스터를 사용한다. 팩토리얼 서브루틴은 낮은 레벨의 문제를 불러낼 때 그 위치(안에 있는 문제를 막 풀기 시작한 곳)를 새로운 값으로 하여 continue 레지스터에 넣는다. 또한 자신을 호출한 곳으로 돌아가려면 다시 예전 값이 필요하다. 그 예전 값은 스택에 저장되어 있다.

(controller

(assign continue (label fact-done)) ; 끝으로 되돌아갈 장소를 지정하는 초기화

fact-loop

(test (op =) (reg n) (const 1))

(branch (label base-case))

;; 되도는 계산(recursive call)을 위한 준비작업으로 n과 continue를 저장한다.

;; 스택에 n과 continue는 계속 쌓인다.

;; 서브루틴에서 돌아올 때 after-fact에서 계속할 수 있도록 continue를 설정

(save continue)

(save n)

(assign n (op -) (reg n) (const 1))

(assign continue (label after-fact))

(goto (label fact-loop))

;;

;;

after-fact

(restore n)

(restore continue)

(assign val (op *) (reg n) (reg val)) ; val에 (n - 1)! 할당

(goto (reg continue)) ; 호출한 곳으로 돌아가기

base-case

(assign val (const 1)) ; 끝에 도달한 경우: 1! = 1

(goto (reg continue)) ; 호출한 곳으로 돌아가기

fact-done) ; 기계가 fact-done에 이르면 계산은 끝나고 val 레지스터 값이 결과가 된다.갑자기 기계어 같은 컨트롤러 코드가 나와서 황당하지만 별다른 것이 아니다. 처음에는 모두 기계어를 썼으니 이런 코드들을 손으로 만들어 보는 것이 당연했을 것이다.

구현 전략은 간단하다. 제어기 시퀀스는 n과 continue에 되도는 계산(recursive call)을 하기 전 값을 저장하고 베이스 케이스인 n=1이 될 때까지 fact-loop 루프를 진행한다. continue와 n 레지스터는 스택에 쌓인다. n=1이 되면 base case에서 val 레지스터에 1을 지정하고 스택에 지정된 continue 위치로 돌아간다(계산이 끝날 때까지는 after-fact로 지정되어 있다). after-fact에서는 계산을 끝내고 난 다음 되돌아가 넣어둔 값을 다시 꺼내도록 한다. 스택을 모두 소비하면 마지막 fact-done으로 가는 구조다(물론 책에 나오는 내용과 다른 구현 방법도 있다). 복잡하게 보이는 내용은 9a의 동영상에 포함되어 있다. 서스만이 칠판에 그리는 내용을 보면 독자들은(영어로 설명하는 장벽을 넘어) 무슨 말을 하려는지 알 수 있을 것이다. 그러니 동영상을 보라!

평범했던 레지스터 기계에 스택 연산을 추가한 팩토리얼 기계를 만들면서 재귀적 계산 방법의 일반적 전략을 살펴볼 수 있다. 책에 나오는 피보나치 수열을 포함하여 더 복잡한 예제들도 비슷한 전략으로 풀어낼 수 있다. 반복이나 재귀나 구현의 차이는 근소하고 스택과 continue 레지스터 사용 전략이 바뀔 뿐이다. 완전히 기계적인 내용이다.

결론적으로 스택이나 레지스터를 잘 조작할 수 있으면 아주 복잡한 문제들도 풀어낼 수 있다. 하부 레벨에서는 단순한 기계적 작업이 더 많아지는 것뿐이다. 기계적으로는 분명히 그렇다. 이 아이디어를 조금 더 확장해 보자. 스택과 continue 레지스터와 비슷한 설비를 갖는 조금 더 복잡한 기계를 만들면 원하는 연산을 수행할 수 있는 범용 처리기가 될 것이다. 우리는 물론 매일 이 기계를 사용하고 있다. 바로 컴퓨터의 프로세서다.

손으로 그려 돌려본 레지스터 머신을 이해했다면 그 다음 행보는 기계의 동작을 수행해보는 것이다. 간단한 레지스터 머신을 시뮬레이트하는 코드는 비교적 쉽게 만들 수 있으며 기계 내부 동작은 투명하게 보인다.

우선 모형 기계(시뮬레이션하려는 기계 부품에 해당하는 데이터 구조)를 만들기 위해 레지스터 기계의 설명(specification)을 사용하는 프로시저가 필요하다. 이 기계를 만들려면 레지스터의 이름을 정의하고 조작들을 정의하며 제어기도 필요하다. 그 형식은 다음과 같다.

(make-machine <register-names><operations><controller>)레지스터, 연산, 제어기를 받아 모형 기계를 내놓는다. 그리고 모형 기계를 조작해 실제 기계를 시뮬레이트하는 프로시저들이 필요하다.

(set-register-contents! <machine-model><register-name><value>)기계의 시뮬레이트된 레지스터에 값을 넣는다.

(get-resister-contents <machine-model><register-name>)기계의 시뮬레이트된 레지스터에서 값을 꺼낸다.